作物遗传改良全国重点实验室生物信息计算平台¶

平台介绍¶

生物信息高性能计算平台为华中农业大学作物遗传改良全国重点实验室公共技术平台,专注为实验室及全校用户提供高通量测序数据的存储和计算服务。

平台由155个刀片计算节点、2个GPU节点、6个八路大内存胖节点、多套并行存储组成,总体计算能力理论峰值为380万亿次,CPU核心数为5600核,存储硬件12.7PB(可用容量8.8PB),主存储读写带宽超过45GB/s。平台预装了1000余款各类生物信息分析软件及相关使用文档、各类常用生物信息数据库,用户可使用本平台进行转录调控测序、单细胞测序、三维基因组测序、表观组测序、基因组组装注释等各类常见组学数据分析。可加速大规模重测序数据分析、复杂大基因组组装注释等需消耗大量资源的分析项目。

Info

此文档右上角搜索框,支持完整的英文搜索,中文搜索分词有限制:搜索连续的两个字相比多个字效果更好,多个字之间建议以空格两两隔开进行搜索,如变异 检测。

集群使用指南¶

1、在满足本实验室正常使用的情况下,面向全校师生开放使用,每学年4次集中考核、申请,见 账号申请 考核范围;收费标准见 集群收费标准

2、修改密码见 修改密码。密码遗忘先使用默认密码登录,如若不行则向管理员申请修改密码。

3、禁止在登录节点运行作业,登录节点运行的程序使用CPU或内存超标会被监控程序杀掉。所有作业应由LSF作业调度系统调度至计算节点运行,LSF使用文档见 作业调度系统LSF使用。

4、集群有多种不同硬件配置,根据硬件配置差异和不同功能需求,集群计算节点划分为多个队列,每个队列的具体使用规则见 作业队列划分。

- 默认用户队列为 normal;

- 程序调试使用 interactive 队列(交互模式);

- gpu 程序使用 gpu 队列;

- 超大内存作业使用 smp 队列;

- 多节点并行作业使用 parrallel 队列等。

5、lsf 作业资源申请规则及注意事项:

- lsf作业申请资源时需遵守资源申请的基本规则,即申请的CPU核心数和程序使用的线程数相等,避免集群资源的浪费或者节点负载过高,如果违反规则导致资源大规模浪费,账号将会被暂停提交作业一段时间或降低可使用的核心数;

- 作业使用内存较多时,需在lsf作业脚本中申请使用的内存大小, 如

-R "rusage[mem=20GB]"; - 提交到 normal、high 队列的作业每核可使用内存分别不超过5G、10G,否则作业被将被系统杀掉(

TERM_ MEMLIMIT: job killed after reaching LSF memory usage limit.),具体说明见 作业队列划分。同时建议定制bjobs命令输出内容,方便查看作业内存使用,具体见 LSF 作业查询; - 申请多个核心并不能加速单线程作业的运行,即perl、R、python等脚本作业使用一个核心即可;

- 建议使用LSF的环境变量

$LSB_DJOB_NUMPROC来设置程序使用的线程数,方便动态调整; - 有画图等图形界面任务需求,使用

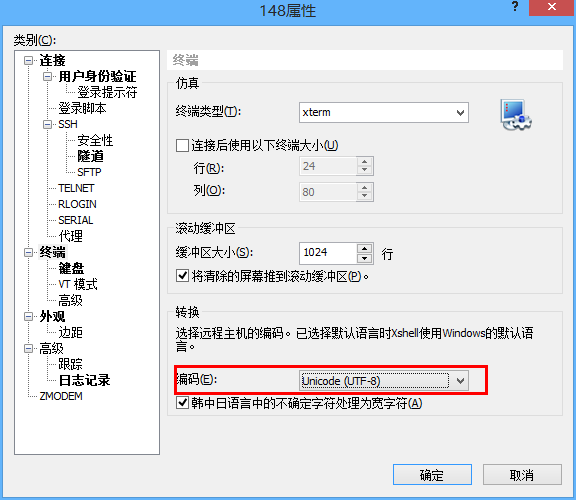

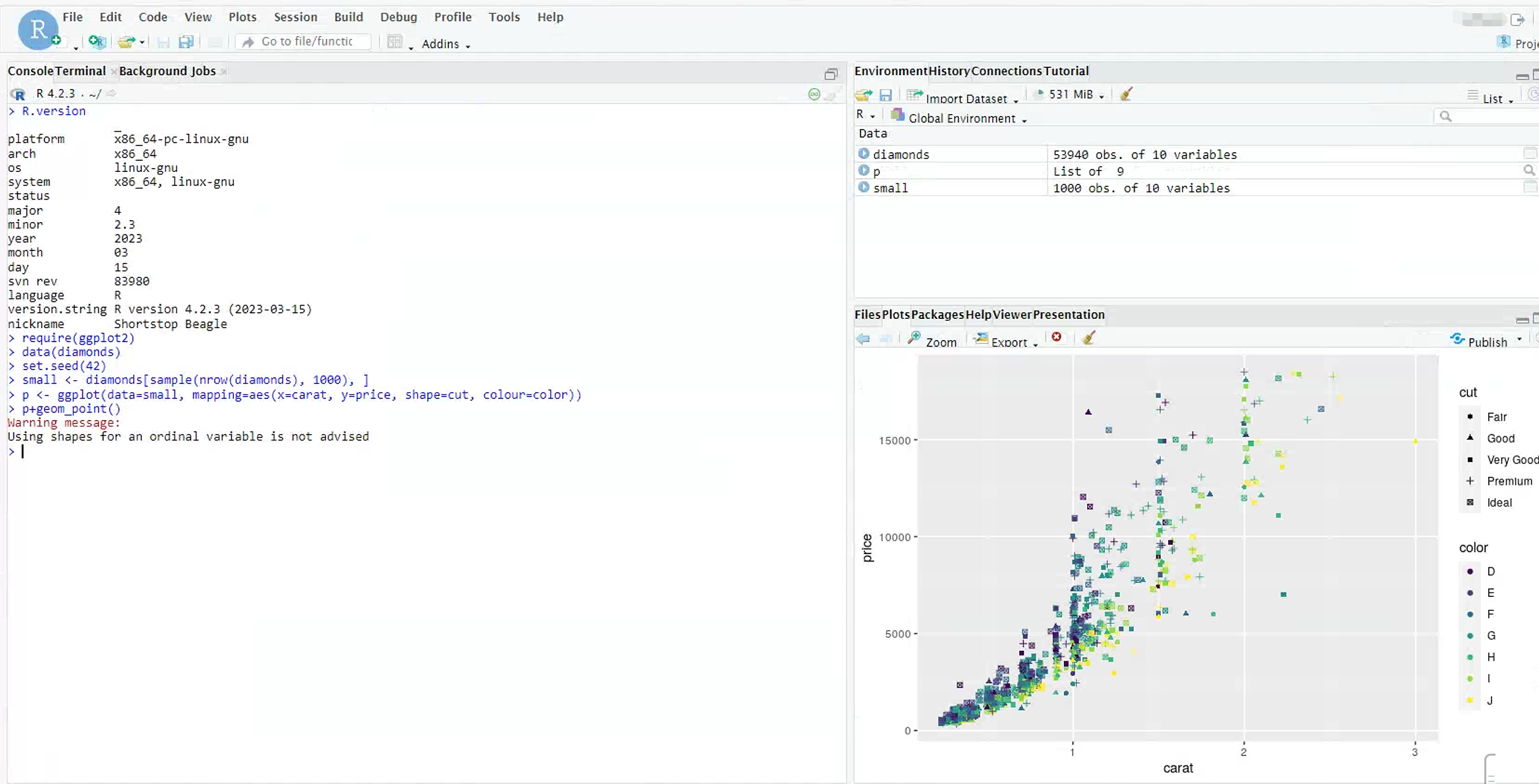

bsub -q interactive -XF -Is bash命令交互进入计算节点进行(xshell需要设置好图形转发),R 画图也可使用 Rstudio,见 集群 Rstudio 使用; - 更多的使用细节见 作业调度系统LSF使用。

6、每个用户可使用的计算和存储资源有一定限制,见 用户资源限制。数据较多、作业任务较多的用户建议时常使用diskquota命令查看自己的存储使用量,以免因为存储空间达到配额限制导致程序挂掉。存储超配额后,无法写入数据,同时也无法登录集群,均会出现 Disk quota exceeded 的报错。

7、集群存储只存储用户目前使用的数据,结果数据应该及时下载到本地,计算中间数据及时删除。测序原始数据一定要在本地备一份。长时间不使用的数据及时压缩后备份到本地,避免额外的存储使用费用。

8、集群装有若干公共应用软件、基础库以及NR、NT等生信数据库,用户可使用module、singularity来查看和调用,见 集群软件使用介绍。有些生信软件在集群使用使用会有一些注意事项,可在本系统上查看相关文档。

9、如果群体数据较多,测试 GATK HaplotypeCaller 运行较慢,可以使用 deepvariant。或使用GPU进行加速的call变异工具 parabricks,人重 30x WGS测试数据,fq->vcf全流程3h,call变异bam->vcf大约20min。

10、大批量的群体数据处理时,不要直接保留sam文件,见 短序列比对输出bam, 数据使用规范 。群体数据处理过程中会使用大量的存储空间,建议群体数据处理过程中时常使用diskquota命令查看自己的存储使用量,以免存储使用达到配额限制导致程序挂掉或空跑,见 存储限制。

11、简单分析流程可以使用LSF处理,见 LSF提交批量流程作业。复杂分析流程,建议使用生信专用流程工具 snakemake或 nextflow,前者依赖python3,上手相对简单,容易理解,复杂脚本编写符合python语法;后者依赖java环境,理解和上手较复杂,复杂场景编写脚本需要使用java语法。

集群相关 ↵

1. 常用命令无法使用¶

用户编辑~/.bashrc 时,PATH 环境变量相关的部分编写错误,会导致出现下面这种常用命令无法使用的情况。

$ cat test.txt

bash: cat: command not found...

~/.bashrc,将写错的部分改正,重新开个登录窗口即可。

$ /bin/vim ~/.bashrc

2. module av显示的软件很少¶

使用系统module之前,需要先设置相关环境变量,否则会出现module av 显示的软件很少,或module load 无法载入某个软件的情况。module环境配置见 Module使用

3. 节点/tmp空间不够¶

部分节点可能会因为作业在/tmp目录下写入的文件过多,导致系统盘耗尽,进而导致作业无法往/tmp目录内写入临时文件,出现类似如下的报错。

cannot create temp file for here-document: No space left on device

使用lsload命令查看该节点的资源信息,可看到tmp剩余空间为0,请联系管理员,清理/tmp目录。

$ lsload c01n01

HOST_NAME status r15s r1m r15m ut pg ls it tmp swp mem

c01n01 ok 8.0 7.8 7.9 22% 0.0 0 4226 0 3.7G 241G

作业本身不往/tmp目录下写入很多数据,是其它作业把/tmp目录写满了。可以使用lsf相关选项,重新投递出错的作业到其它/tmp目录有空闲的节点。

-R "select[tmp>10G]"

作业本身需要往/tmp内写入大量的数据,建议使用TMP 环境变量重新设置临时目录到本地。有多个类似作业时,建议每个作业一个目录,避免文件重名程序出错。bs_seeker repex_tarean paragraph等都会往/tmp目录下写入大量的数据,使用时注意设置TMP环境变量。

#BSUB -J program

#BSUB -n 10

#BSUB -R span[hosts=1]

#BSUB -o %J.out

#BSUB -e %J.err

#BSUB -q normal

tmpn=`mktemp -u programname_XXXXX`

tmpd="${HOME}/tmp/${tmpn}"

mkdir -p ${tmpd}

echo ${tmpd}

export TMP=${tmpd}

# 运行程序

program...

# 清理临时文件

rm -r ${tmpd}

4. 存储超过配额¶

写入数据或程序运行时出现 Disk quota exceeded的报错,说明存储空间或文件数超过配额。diskquota 查看存储使用情况,清理账号下的数据至配额之下方可正常写入数据。建议对所有数据扫描一遍,压缩删除不必要的数据,参考 文件扫描。如果需要增加存储配额,可按这个步骤处理申请增加配额。

$ diskquota

Filesystem type blocks quota limit in_doubt grace | files quota limit in_doubt grace Remarks

public USR 43.74T 20T 20T 0 7 days | 9890452 17500000 17500000 0 none

$ cp data/NT/taxdb.btd.gz .

cp: error writing ‘./taxdb.btd.gz’: Disk quota exceeded

cp: failed to extend ‘./taxdb.btd.gz’: Disk quota exceeded

5. github/singularity 下载缓慢¶

参考 网络加速

6. 登录节点使用conda安装软件等待时间过长¶

conda安装软件过程中,会运行python程序,如果此时间过长,会被监控程序判定为在登录节点跑作业进而将相关python程序杀掉,导致conda安装过程一直处于等待状态,建议进入交互节点后再使用conda安装程序。R包安装过程也有类似问题,建议在交互节点安装R包。

此外conda安装软件时,刚开始的resolving时间可能会很长,建议使用mamba替代conda,见 mamba使用。

7. 新版conda命令行提示符异常¶

conda升级到22.9.0之后,激活conda环境出现如下的命令行提示符显示异常

(base)

(base)

conda init bash

(base) [username@login01 ~]$

8. 'GLIBC_x.xx' not found¶

软件运行时出现类似version 'GLIBC_2.29' not found 的报错,一般是系统上glibc版本比较低导致的,解决方法见集群文档 glibc。

9. 'GLIBCXX_x.x.x' not found¶

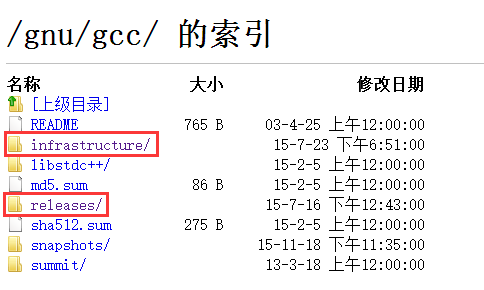

部分应用程序使用高版本GCC编译,直接在集群上运行时,由于集群默认GCC版本较低(gcc 4.8.5),会出现类似如下的'GLIBCXX_x.x.x' not found报错。

$ ./program

program: /lib64/libstdc++.so.6: version 'GLIBCXX_3.4.20' not found(required by program)

module load GCC/5.4.0-2.26。

常用GCC版本与GLIBCXX的对应版本如下所示,完整列表见:ABI Policy and Guidelines

GCC 4.8.0: GLIBCXX_3.4.18, CXXABI_1.3.7

GCC 4.8.3: GLIBCXX_3.4.19, CXXABI_1.3.7

GCC 4.9.0: GLIBCXX_3.4.20, CXXABI_1.3.8

GCC 5.1.0: GLIBCXX_3.4.21, CXXABI_1.3.9

GCC 6.1.0: GLIBCXX_3.4.22, CXXABI_1.3.10

GCC 7.1.0: GLIBCXX_3.4.23, CXXABI_1.3.11

GCC 7.2.0: GLIBCXX_3.4.24, CXXABI_1.3.11

GCC 8.1.0: GLIBCXX_3.4.25, CXXABI_1.3.11

GCC 9.1.0: GLIBCXX_3.4.26, CXXABI_1.3.12

GCC 9.2.0: GLIBCXX_3.4.27, CXXABI_1.3.12

GCC 9.3.0: GLIBCXX_3.4.28, CXXABI_1.3.12

GCC 10.1.0: GLIBCXX_3.4.28, CXXABI_1.3.12

GCC 11.1.0: GLIBCXX_3.4.29, CXXABI_1.3.13

GCC 12.1.0: GLIBCXX_3.4.30, CXXABI_1.3.13

GCC 13.1.0: GLIBCXX_3.4.31, CXXABI_1.3.14

10. 常用库缺失解决¶

在安装或运行软件过程中经常出现类似 xxxx.so.1.0: cannot open shared object file: No such file or directory的库缺失报错,一般加载或安装对应的库文件即可。

| 缺失库 | 需要加载的库 |

|---|---|

| libbz2.so.1.0 | module load bzip2/1.0.6 |

| libgsl.so.23 | module load GSL/2.4 |

| liblzma.so.0 | module load XZ/5.2.4 |

| libgeos_c.so.1 | module load GEOS/3.7.1 |

| libicuuc.so.42 | module load icu/42 |

| libzstd.so.1 | module load zstd/1.5.0 |

| libjemalloc.so.2 | module load jemalloc/5.2.1 |

| libpng16.so.16 | module load libpng/1.6.24 |

| ltld.so | module load libtool/2.4.6 |

| libpcre2-8.so.0 | module load PCRE/10.00 |

| libglpk.so.40 | module load glpk/5.0 |

| libiconv.so.2 | module load libiconv/1.18 |

11. core dumped¶

造成"core dumped"错误的原因可能有多种,包括:

-

程序Bug:程序中存在错误、内存泄漏或未处理的异常,导致程序崩溃。在这种情况下,需要检查程序代码并修复错误,或向开发人员求助;

-

输入数据有问题。检查输入数据是否符合要求,或更换其他数据尝试;(如bsmap,参考基因组序列需要多行的格式,单行就出现core dump报错)

-

节点内存不够:程序使用的内存超过了系统可用的内存导致出错。可以更换内存更大的节点尝试;

12. too many open files¶

too many open files 报错的原因一般是某个进程打开了超过系统限制的文件数量,默认值为1024,非root用户可以使用命令设置到4096。

在本集群运行此作业如出现此报错,可在lsf脚本中添加 ulimit -n 4096 命令就可以临时将本账号的限制最大提升至4096,大于此值会出现权限不够的报错;如果还出现此报错,建议使用smp队列,smp队列中此值为32768;如果32768也不够,请联系管理员处理。

13. 软件离线运行¶

基于安全考虑,计算节点未联网,导致部分在运行过程中需要联网的软件无法正常运行,暂无统一解决办法,各软件离线运行方案如下。遇到类似问题可联系管理员协助处理。

-

部分WDL流程会在运行过程中下载singularity镜像,计算节点未联网会导致流程运行失败。解决办法为,在登录节点下载好镜像,然后替换WDL脚本中的镜像URL。如 atac-seq-pipeline 的WDL脚本中有2个地方用到了

https://encode-pipeline-singularity-image.s3.us-west-2.amazonaws.com/atac-seq-pipeline_v2.2.2.sif,首先下载这个镜像,然后将这个URL替换成DIR/atac-seq-pipeline_v2.2.2.sif即可 - nf-core 流程离线运行,见 nf-core

- nextflow 脚本离线运行需配置

export NXF_OFFLINE='true'

集群硬件资源¶

计算资源¶

本集群在2018年新购置的联想集群基础上,将2014年购置的曙光集群并入其中,共计2个管理节点,4个登陆节点,155个刀片计算节点,2个GPU节点,6个八路胖节点,各节点详细硬件配置如下:

| 节点类型 | 公司 | 投入使用年份 | 节点名称 | 节点数量 | CPU型号 | 核心数 | 内存 |

|---|---|---|---|---|---|---|---|

| 管理节点 | 联想 | 2019.2 | mn01 | 1 | Intel(R) Xeon(R) Gold 5115 CPU @ 2.40GHz | 20 | 96GB |

| 备用管理节点(登录节点) | 联想 | 2019.2 | mn02 | 1 | Intel(R) Xeon(R) Gold 5115 CPU @ 2.40GHz | 20 | 96GB |

| 登录节点 | 曙光 | 2014.12 | login01-04 | 4 | Intel(R) Xeon(R) CPU E5-2630 v2 @ 2.60GHz | 12 | 64GB |

| 刀片计算节点1 | 联想 | 2019.2 | c01n01-c04n03 | 45 | Intel(R) Xeon(R) Gold 6150 CPU @ 2.70GHz | 36 | 384GB |

| 刀片计算节点2 | 联想 | 2019.2 | c04n04-c07n11 | 50 | Intel(R) Xeon(R) Gold 6150 CPU @ 2.70GHz | 36 | 192GB |

| 刀片计算节点3 | 曙光 | 2014.12 | sg01-30 | 30 | Intel(R) Xeon(R) CPU E5-2680 v2 @ 2.80GHz | 20 | 128GB |

| 刀片计算节点4 | 曙光 | 2014.12 | sg31-60 | 30 | Intel(R) Xeon(R) CPU E5-2680 v2 @ 2.80GHz | 20 | 256GB |

| GPU节点1 | 联想 | 2019.2 | gpu01 | 1 | Intel(R) Xeon(R) CPU E5-2680 v2 @ 2.80GHz | 36(两块GPU加速卡,P100) | 512GB |

| GPU节点2 | 曙光 | 2014.12 | gpu02 | 1 | Intel(R) Xeon(R) Gold 6140 CPU @ 2.30GHz | 20(两个GPU加速卡,Tesla K40m) | 256GB |

| 胖节点1 | 联想 | 2019.2 | s001-s004 | 4 | Intel(R) Xeon(R) Platinum 8160 CPU @ 2.10GHz | 192 | 2TB |

| 胖节点2 | 曙光 | 2014.12 | s005 | 1 | Intel(R) Xeon(R) CPU E7-8850 v2 @ 2.30GHz | 96 | 4TB |

| 胖节点3 | 曙光 | 2014.12 | s006 | 1 | Intel(R) Xeon(R) CPU E7-8850 v2 @ 2.30GHz | 96 | 2TB |

存储资源¶

本集群公共存储采用联想DSS高性能存储(IBM ESS同架构),文件系统采用HPC行业广泛使用的IBM GPFS (现名为 IBM Spectrum Scale)文件系统。

公共存储硬件由2套DSS存储组成,每套DSS存储含2台IO节点和6台84盘位磁盘柜,总计4台IO节点,12台磁盘柜,1000余块8TB硬盘。所有硬盘由GPFS文件系统管理,采用了GPFS Declustered RAID冗余策略,实现了8+2数据冗余,并具有统一的用户映像(即所有硬盘由文件系统虚拟成一个data pool,可挂载在单一目录下),实测存储读写带宽达50GB/s。系统挂载目录为/public,可用容量约为5.5PB(1PB=1024TB)。

部分课题组采购了存储硬件挂载集群上,相应课题组的用户可直接使用。这部分的存储性能不及公共存储,如有大规模对存储IO要求较高的作业,建议在公共存储上进行。

存储使用注意事项:为了平衡存储的性能和利用率,GPFS配置的 sub block size(硬盘空间分配的最小尺寸)为128K,即比较小的文件(十几KB,几十KB),其占据的硬盘空间为128KB,因此对于比较小的文件(如解压后的软件源码包等)建议及时删除,减少磁盘空间浪费。

网络资源¶

集群存储节点、计算节点、以及登录节点之间用2套网络进行互联。

存储网络:采用56Gbps的Infiniband网络,存储网络和计算网络采用同一网络;

管理网络:采用千兆以太网,主要用于集群各节点间互联及管理系统;BMC硬件管理网络复用管理网络。

内网网络:登录节点login03配备了内网万兆光纤,直连到二综B座的生物信息室(B111)及附近的办公室,以便于大量数据的上传下载(速度可达100MB/s)。有大量数据传输的用户可联系B111的同学或者管理员帮忙。实验室测序平台测序仪也通过内网直连集群,测序仪下机数据如在本集群存储和分析,可由测序平台负责人直接将其上传到相应目录后再由用户拷贝到自己的账号下分析,避免使用移动硬盘来回拷贝,节省时间。

计算资源限制¶

系统对每个用户提交的作业数无限制,每个用户所有正在运行的作业同时使用的CPU核心总数限制白天为400核,夜间10点至第二天早晨6点为400核。

每个队列的内存、可用核数、用户限制略有不同,具体见 作业队列划分。

集群运行过程中,根据实际情况会略有调整,具体每个队列资源定义和限制,可使用bqueues -l 队列名 查看。

根据集群使用情况,当集群计算资源非常紧张时,可能会适当调低每个人最多能同时使用的CPU核心总数。

存储资源¶

目前对每个新用户所能使用的存储空间限制为10TB,有需要可以逐步调高到20TB,文件数限制为300万,课题组总的存储空间限制为400TB,任何一项超过阈值时,账号无法写入数据。当系统总的存储使用过高时会通知大家清理数据。

查看账号存储使用¶

用户可使用diskquota 命令查看当前存储使用量和配额,避免写满。特别是当有产生大量中间文件和结果文件的作业运行时,需时时关注,及时清理,以免超过配额。由于海量的小文件(小于128KB)会对存储系统性能有一定影响,因此大量小文件使用完之后需要即使删除或者打包压缩存放。

如下,当前的存储使用量为17.55TB,存储配额为20TB;账号下文件数据量为2145851,文件数配额为8000000;

$ diskquota

Filesystem type blocks quota limit in_doubt grace | files quota limit in_doubt grace Remarks

public USR 17.55T 20T 20T 108.1G none | 2145851 8000000 8000000 2966 none

Disk quota exceeded。清理账号下的数据至配额之下方可正常写入数据。

$ diskquota

Filesystem type blocks quota limit in_doubt grace | files quota limit in_doubt grace Remarks

public USR 43.74T 20T 20T 0 7 days | 9890452 17500000 17500000 0 none

$ cp data/NT/taxdb.btd.gz .

cp: error writing ‘./taxdb.btd.gz’: Disk quota exceeded

cp: failed to extend ‘./taxdb.btd.gz’: Disk quota exceeded

申请增加配额¶

如果因有较大项目需要大量存储时,可向管理员申请增加存储配额。在向管理员申请增加配额之前,需要先做以下几步:

-

先扫描账号下所有 大于100M的文本文件,将其中的fastq、fasta、sam、vcf、hmp、txt、csv等需要保留的文件进行压缩,将其它不需要的中间文件、日志文件等删除;然后再扫描大于100M的所有文件,时间较长的原始数据、程序运行的中间文件、冗余的bam文件等都可以删除,冗余数据的压缩清理见 数据使用规范。这2步清理完成之后再扫描大于100M的所有文件,扫描的结果发给管理员。扫描方式参考 文件扫描;

-

所有暂时不用的大批量fastq、bam、vcf等文件,需使用 genozip 压缩;

-

测试运行一个样本,并告知管理员中间数据和结果数据的路径,以及总的原始数据的大小、样本数量和运行脚本,以便管理员评估所需存储空间;

Info

流程规定得这么繁琐的目的是督促用户清理数据,避免浪费,因此用户之间不允许调剂配额;平常注意扫描数据、清理数据,到存储不够了再走申请配额的流程比较耽误时间;

集群登录方式为动态口令+密码,不支持密码和秘钥登录,集群可在校内和校外登录。校内登录IP地址和端口见管理员发送的账号信息邮件,校外登录专用的IP地址和端口号见登录集群后的欢迎信息提示。

集群登录IP地址和端口以下以 ip 和 port 代称。

登录节点生成密钥¶

在校园网内登录个人的集群帐号(登录节点 mn02 ) ,运行命令 google-authenticator -C -Q NONE -t -f -d -r 3 -R 30 -w 3 ,即可生成用于手机端生成动态口令的密钥(secret key)以及备用登录口令,备用登录口令在手机端无法生成口令时使用,务必妥善保管,过程如下所示:

google-authenticator -C -Q NONE -t -f -d -r 3 -R 30 -w 3

Your new secret key is: URUUTDFSZJLINDA6WYNCPFLBOQ

Your verification code for code 1 is 984971

Your emergency scratch codes are:

65741623

35546844

93420918

73609925

99156164

-C: 运行google-authenticator命令时不做人工确认-Q NONE: 不生成二维码-t:基于TOTP生成验证码-f: 将配置保存到~/.google_authenticator-d: 不允许重复使用以前使用的令牌-r 3 -R 30: 限速,每 30 秒允许 3 次登录-u:不限速-w 3: 允许的令牌的窗口大小。默认情况下,令牌每 30 秒过期一次。窗口大小 3允许在当前令牌之前和之后使用令牌进行身份验证以进行时钟偏移。

Warning

google-authenticator 命令运行完成之后,注意检查~/.google_authenticator文件是否存在ls ~/.google_authenticator。

账号的home目录权限只限于700或750,others权限不可开放,以及~/.google_authenticator文件的权限仅为400,否则二次验证会失败无法登录账号。

由于二次验证登录设置了登录次数限制,即 30 秒内尝试登录次数为 3 次,请勿短时间内不断尝试登录。

手机客户端生成动态验口令¶

app安装¶

在安卓的应用商店输入"身份验证器"或"google authenticator",IOS应用商店内输入"google authenticator"以搜索安装google authenticator身份验证软件。每个安卓应用商店搜索出来的软件不太一样,如小米应用商城搜索出来的为微软的"Authenticator",使用方式都大同小异。也可在集群用户qq群内群文件中下载google authenticator安卓安装包。

安卓手机也可以下载其它 TOTP 客户端APP 酷安

app设置¶

以google authenticator为例

-

点击"开始设置"

-

点击"手动输入动态口令"

-

填写账户信息

在"账户"内随便填方便标识的字符串,有多个账户时方便标识,此处填写的"账户"与服务器账户无关。密钥内填上文中运行

google-authenticator命令生成的的密钥(secret key)URUUTDFSZJLINDA6WYNCPFLBOQ,每个人均不相同。软件根据该密钥生成对应的6位数动态口令,动态口令每30s自动更新一次。

Warning

此处的动态口令基于时间生成,登录节点的时间已经与标准时间同步,因此如果手机时间有误,则生成的动态口令不可用,每个动态口令只能使用一次。

密钥和备用口令位于 ~/.google_authenticator 内,如果遗忘密钥或更换手机,可查看该文件内的密钥重新设置app以生成动态口令。建议将秘钥在电脑上备份,以便更换手机后能重新设置app生成动态口令。

客户端登录¶

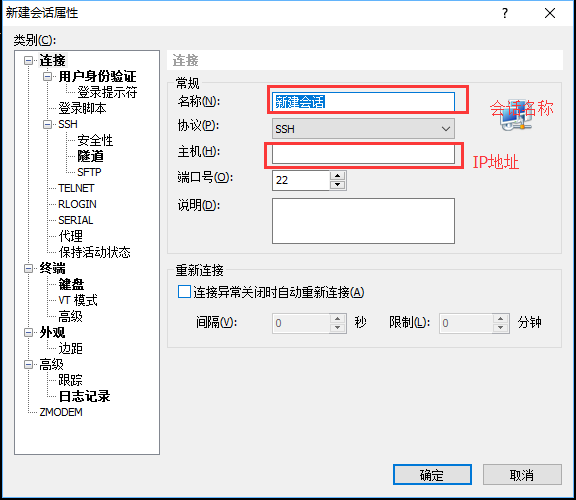

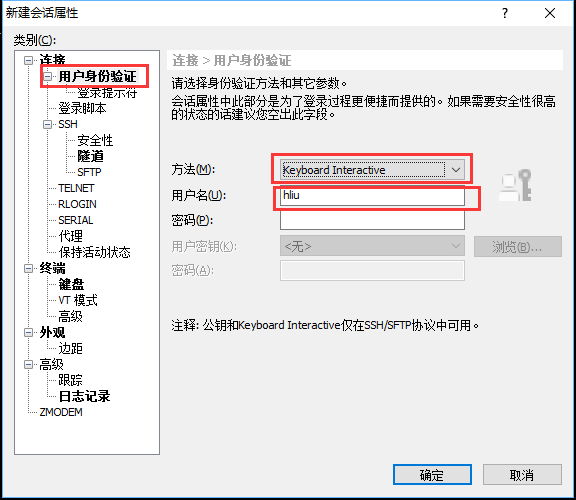

Windows¶

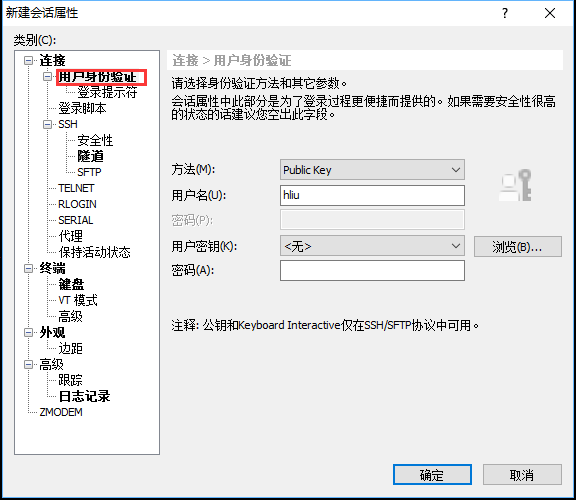

以xshell为例,IP地址和端口为 ip 和 port ,用户名和密码为个人的集群用户名和密码。

-

新建xshell会话,填写"会话名称"以及"IP地址"

-

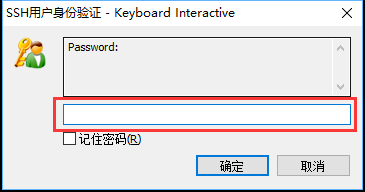

点击右侧的"用户身份验证",身份方法选择"Keyboard Interactive",不能勾选"password",用户名填写服务器用户名,密码空着不能填写,点击确定。

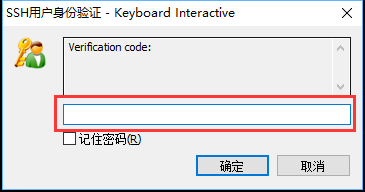

-

尝试连接服务器,弹出"Verification code"窗口,填写手机上显示的6位数动态口令,点击确定。

-

在弹出的"Password"窗口内填写服务器用户密码,点击"确定"即可登录到服务器。如果出现

keyboard-interactive身份验证失败。请再试一次的报错,则需要重新输入动态口令和密码。 -

xshell成功登录之后,如果需要传输数据,可以点击xshell的sftp按钮,打开sftp,同时也会弹出与xshell类似的窗口以输入动态口令和用户密码。

linux/mac¶

使用ssh命令登录,IP地址和端口为 ip 和 port ,用户名和密码为个人的集群用户名和密码。

注意不同的系统,指定登录端口的选项略有不同,有的选项为 -p (小写),有的选项为 -P (大写),如果出现端口相关的报错请更换选项。

$ ssh -p port username@ip

Verification code:

Password:

Last login: Wed Dec 8 16:55:49 2021 from xxx.xxx.xxx.xxx

数据传输¶

工具推荐:Xftp(Windows 推荐)、WinSCP、Termius (macOS 推荐)、FileZilla(支持Windows、Linux、Mac OS三种平台)。

Xftp¶

Xftp 如长时间连接后传输文件出错,设置 会话 (Sessions)->属性 (Properties)->选项 (Options)->仅使用主连接 (Use main connection only)。

WinSCP¶

WinSCP 不可使用后台传输 (Background Transfers)

FileZilla¶

二次验证设置

文件->站点管理器->新站点->协议:sftp->填写ip和端口->登录方式:交互式->用户:个人账号->连接

第一个弹窗输入6位动态口令,第二个弹窗输入个人账号密码

FileZilla 长时间空闲不操作连接会中断,须在站点 (Site)->传输设置 (Transfer Settings)->勾选限制并发连接数 (Limit number of simultaneous connections)->设置最大连接数 (Maximum number of connections)为1。

其它¶

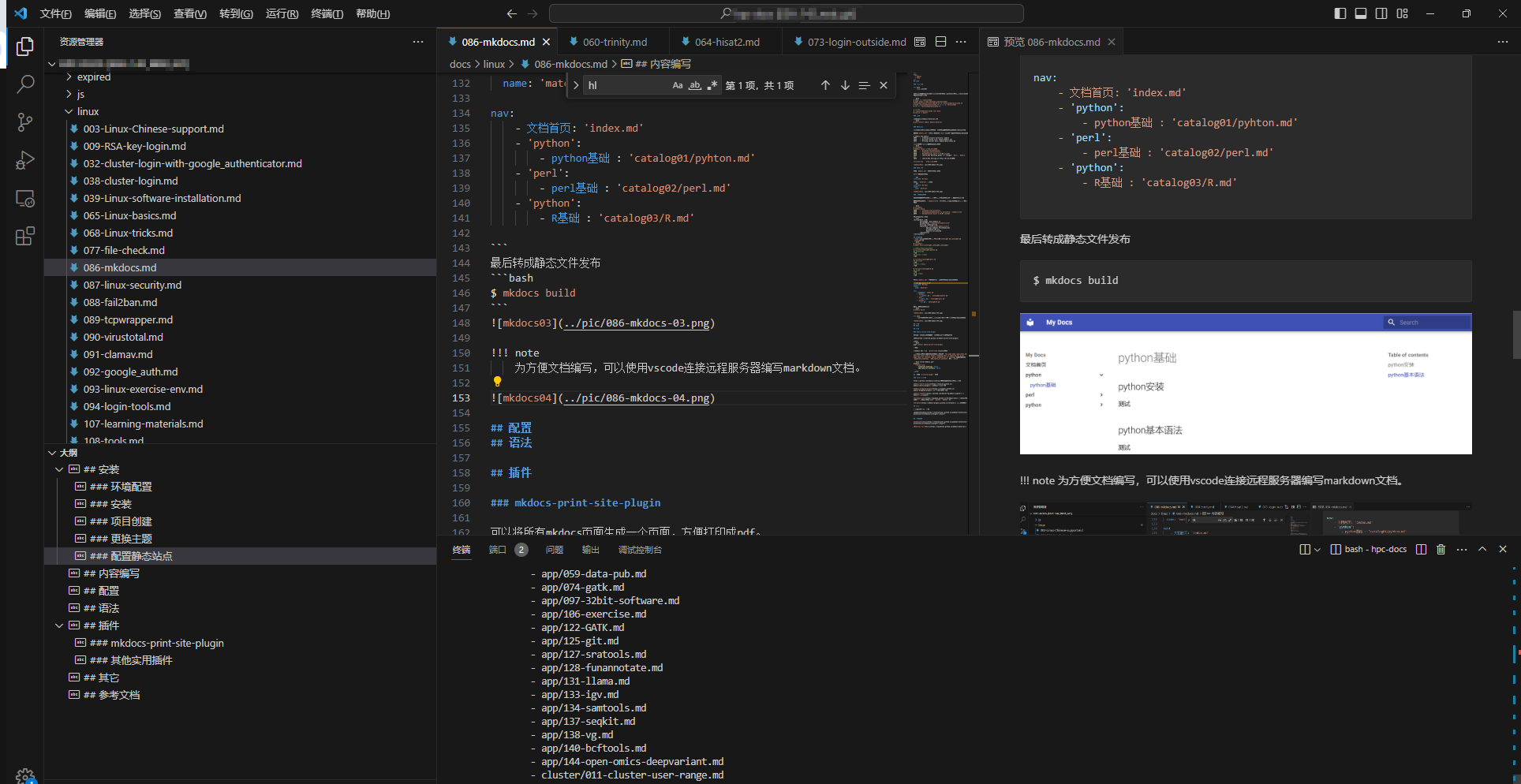

vscode¶

在config文件中添加 KbdInteractiveAuthentication yes 以便连集群时进行二次验证。

Host cluster

HostName login_ip

User username

Port login_port

KbdInteractiveAuthentication yes

从其它服务器登录或传输数据¶

本集群的安全策略禁止在校内其它服务器上通过ssh登录本集群及使用scp往本集群传输数据。

如果需要从校内其他服务器往本集群上传输数据,可以在本集群上运行如下命令,即在本集群上使用scp获取在其他服务器上的数据。

$ scp -p port -r dir user@remote:~

Warning

在校外登录时,部分单位的网络环境中,可能单位的防火墙不允许使用非22端口对外登录服务器,表现为确认使用的登录IP和端口正确无误后,登录时仍然无法弹出输入动态口令和密码的窗口。建议与网络管理员沟通放行该端口,或者使用手机热点网络登录集群。

LSF 基本使用¶

LSF(Load Sharing Facility)是IBM旗下的一款分布式集群管理系统软件,负责计算资源的管理和批处理作业的调度。它给用户提供统一的集群资源访问接口,让用户透明地访问整个集群资源。同时提供了丰富的功能和可定制的策略。LSF 具有良好的可伸缩性和高可用性,支持几乎所有的主流操作系统。它通常是高性能计算环境中不可或缺的基础软件。

LSF的功能和命令非常多,这里主要介绍普通用户常用命令,更详细的命令文档参见 IBM Spectrum LSF command reference。

提交作业¶

LSF命令行提交作业¶

与PBS不同,大部分情况下,可以不需要写作业脚本,直接一行命令就可以提交作业

bsub -J blast -n 10 -R span[hosts=1] -o %J.out -e %J.err -q normal "blastn -query ./ZS97_cds.fa -out ZS97_cds -db ./MH63_cds -outfmt 6 -evalue 1e-5 -num_threads \$LSB_DJOB_NUMPROC"

LSF脚本1-串行作业(单节点)¶

LSF中用户运行作业的主要方式为,编写LSF作业脚本,使用bsub命令提交作业脚本。如下所示为使用LSF脚本blastn.lsf

#BSUB -J blast

#BSUB -n 10

#BSUB -R span[hosts=1]

#BSUB -o %J.out

#BSUB -e %J.err

#BSUB -q normal

# 注意-num_threads是blastn的线程设置参数,不同软件参数不同

# 如果软件没有明确有设置线程数的参数,则不设置,默认使用单线程,作业也只需申请一个CPU核心

blastn -query ./ZS97_cds.fa -out ZS97_cds -db ./MH63_cds -outfmt 6 -evalue 1e-5 -num_threads $LSB_DJOB_NUMPROC

提交作业blastn.lsf

bsub < blastn.lsf

脚本中每行内容解释

- -J 指定作业名称

- -n 作业使用核心数,LSF中一般称之为slot

- -R span[hosts=1] 指定作业只能在单个节点运行,不能跨节点(跨节点作业需要MPI支持,生物中比较少)。-R 可以使得作业在需要满足某种条件的节点上运行,常用的有

-R "rusage[mem=20GB]",表示作业预计消耗的内存为20G,节点需要为作业预留20G内存,消耗内存较大的作业需要合理设置该选项,以避免多个作业挤在一个节点而导致节点因内存耗尽而挂掉,内存也不可写得太大,否则会导致大量节点因为要预留很多内存,而不能接收新的作业,造成资源浪费;-R "select[maxmem>224800]",表示选择节点物理内存大于224800MB的节点来运行当前作业,需要使用大内存节点时,可以使用此选项。多个-R 选项可以组合,如-R "span[hosts=1] rusage[mem=20GB] select[maxmem>224800]"。 - -o 作业标准输出,%J为作业ID,即此处的作业输出文件为 jobid.out

- -e 作业错误输出,%J为作业ID,即此处的作业输出文件为 jobid.err

- -q 作业提交的作业队列

Note

$LSB_DJOB_NUMPROC 为LSF系统变量,表示作业脚本申请的CPU核心数。建议所有作业都使用这个变量设置程序使用的线程数,方便动态调整以及作业脚本申请的核心数和程序设置的线程数保持一致。如blastn使用-num_threads这个参数设置线程数,LSF脚本申请4核用多线程跑时,一般写法为blastn -num_threads 4,LSF脚本内的推荐写法为:用$LSB_DJOB_NUMPROC变量代替4,即 blastn -num_threads $LSB_DJOB_NUMPROC,这样调整LSF -n参数申请不同的核数时,-num_threads 参数可以不用同步调整。

另外还有一些常用选项

- -M 内存控制参数,作业占用的内存超过其指定值时,作业会被系统杀掉。如

-M 20GB -R "rusage[mem=20GB]"申请20GB的内存,且其内存使用量不能超过20G - -m 指定作业运行节点,如

-m c01n01 - -W hh:mm 设置作业运行时间

- -w 作业依赖,方便写流程,如

-w "done(JobA)",作业名为JobA的作业完成之后,该作业才开始运行;作业依赖详细用法 - -K 提交作业并等待作业结束,在写流程时会用得上,可以见后面的例子

- -P 指定project name,如果我们需要统计某个项目消耗的计算资源,如CPU时等,可以将相关的作业都指定为同一个project name,然后根据project name统计资源消耗

- -r rerun选项,即作业失败后自动重新运行,提交大量作业时此选项比较有用

LSF脚本2-并行作业(多节点)¶

#BSUB -J MPIJob ### set the job Name

#BSUB -q normal ### specify queue

#BSUB -n 400 ### ask for number of cores (default: 1)

#BSUB -R "span[ptile=20]" ### ask for 20 cores per node

#BSUB -W 10:00 ### set walltime limit: hh:mm

#BSUB -o stdout_%J.out ### Specify the output and error file. %J is the job-id

#BSUB -e stderr_%J.err ### -o and -e mean append, -oo and -eo mean overwrite

# here follow the commands you want to execute

# load the necessary modules

# NOTE: this is just an example, check with the available modules

module load intel/2018.4

module load mpi/intel/2018.4

### This uses the LSB_DJOB_NUMPROC to assign all the cores reserved

### This is a very basic syntax. For more complex examples, see the documentation

mpirun -np $LSB_DJOB_NUMPROC ./MPI_program

此脚本申请400核,每个节点20个核。

多节点并行作业需要程序本身支持,使用mpirun等MPI命令运行,绝大部分生物软件不支持多节点并行。强行使用,会出现作业申请了并占用了多个节点,但程序实际只使用了一个节点,其它节点无程序运行,造成资源的极大浪费 。如不确定程序是否支持多节点并行,请勿使用,避免资源浪费。

使用系统范围的intelmpi / openmpi时,可以省略-np $ LSB_DJOB_NUMPROC命令,因为程序会自动获取有关核心总数的信息。如果使用不同的MPI库,可能需要明确指定MPI的数量 以这种方式在命令行上进行处理。

LSF批量提交作业¶

批量提交简单作业¶

需要处理的数据样本较多时,手工提交非常繁琐,且容易出错,我们可以编写简单的shell脚本来实现大批量自动提交多个作业(可同时提交上万个作业)。

以跑多样本的STAR为例,将下面的脚本保存为run_STAR.sh,运行该脚本,即可同时提交一批作业,而不用一个个手动提交。

for sample in /public/home/username/work/lsf_bwait/raw_data/*trim_1.fq.gz;do

index=$(basename $sample |sed 's/_trim_1.fq.gz//')

prefix=$(dirname $sample)

star_index=/public/home/username/work/lsf_bwait/star/

gtf=/public/home/username/work/lsf_bwait/MH63.gtf

bsub -J ${index} -n 8 -o %J.${index}.out -e %J.${index}.err -R span[hosts=1] \

"STAR --runThreadN 8 --genomeDir ${star_index} --readFilesIn ${prefix}/${index}_trim_1.fq.gz ${prefix}/${index}_trim_2.fq.gz --outFileNamePrefix ${index}. --sjdbGTFfile $gtf"

sleep 10

done

批量提交分析流程¶

生信中经常会遇到需要跑大量作业以及复杂流程的情况,特别是当流程中使用的软件为多线程和单线程混杂时,如果把所有流程步骤写到同一个shell脚本,并按多线程需要的线程数来申请CPU 核心数,无疑会造成比较大的浪费。

在此建议将流程中的主要运行步骤直接用bsub提交,按需要申请核心数、内存等,需要用上文中提到的bsub的 -K 参数。这里写了一个跑RNA-Seq流程的example,主要是2个脚本,RNA.sh 为具体处理每个样本的流程脚本,在batch_run.sh 对每个样本都提交运行RNA.sh脚本。

使用时,提交batch_run.lsf脚本即可, bsub < batch_run.lsf 。

RNA.sh

#!/bin/sh

sample=$1

index=$(basename $sample |sed 's/_trim_1.fq.gz//')

prefix=$(dirname $sample)

star_index=/public/home/username/work/lsf_bwait/star/

gtf=/public/home/username/work/lsf_bwait/MH63.gtf

bsub -K -J STAR1 -n 8 -o %J.STAR1.out -e %J.STAR1.err -R span[hosts=1] "module purge;module load STAR/2.6.0a-foss-2016b;STAR --runThreadN 8 --genomeDir ${star_index} \

--readFilesIn ${prefix}/${index}_trim_1.fq.gz ${prefix}/${index}_trim_2.fq.gz \

--outSAMtype SAM --readFilesCommand zcat --alignIntronMax 50000 --outFileNamePrefix ${index}. --sjdbGTFfile $gtf --outReadsUnmapped None"

bsub -K -J STAR2 -n 1 -o %J.STAR2.out -e %J.STAR2.err -R span[hosts=1] "grep -E '@|NH:i:1' ${index}.Aligned.out.sam >${index}.Aligned.out.uniq.sam"

bsub -K -J STAR3 -n 2 -o %J.STAR3.out -e %J.STAR3.err -R span[hosts=1] "module purge;module load SAMtools/1.3;samtools sort -@2 ${index}.Aligned.out.uniq.sam > ${index}.Aligned.out.bam"

rm ${index}.Aligned.out.sam

rm ${index}.Aligned.out.uniq.sam

rm ${index}.Aligned.out.uniq.bam

bsub -K -J STAR4 -n 1 -o %J.STAR4.out -e %J.STAR4.err -R span[hosts=1] "module purge;module load HTSeq/0.8.0;htseq-count -f bam -s no ${index}.Aligned.out.bam -t gene $gtf >${index}.Genecounts 2>${index}.htseq.log"

batch_run.lsf

#BSUB -J STAR

#BSUB -n 1

#BSUB -R span[hosts=1]

#BSUB -o %J.out

#BSUB -e %J.err

for sample in /public/home/username/work/lsf_bwait/raw_data/*trim_1.fq.gz;do

index=$(basename $sample |sed 's/_trim_1.fq.gz//')

sh RNA.sh ${sample} &

sleep 10

done

wait

不合理批量提交方式¶

如下这个脚本所示,在一个lsf脚本内循环跑多个样本,即一个样本跑完之后才能跑下一个,每个样本的运行时间较长,这样不能充分利用集群节点多、核多的优势,比较浪费时间,因此如果不是有特殊需求,不建议使用这种方式跑多个样本的作业。

#BSUB -J STAR

#BSUB -n 8

#BSUB -R span[hosts=1]

#BSUB -o %J.out

#BSUB -e %J.err

for sample in /public/home/username/work/lsf_bwait/raw_data/*trim_1.fq.gz;do

index=$(basename $sample |sed 's/_trim_1.fq.gz//')

prefix=$(dirname $sample)

star_index=/public/home/username/work/lsf_bwait/star/

gtf=/public/home/username/work/lsf_bwait/MH63.gtf

STAR --runThreadN 8 --genomeDir ${star_index} --readFilesIn ${prefix}/${index}_trim_1.fq.gz ${prefix}/${index}_trim_2.fq.gz --outFileNamePrefix ${index}. --sjdbGTFfile $gtf"

sleep 10

done

大批量小作业提交¶

由于作业排队调度和退出需要一定时间,如果每个作业内程序运行时间很短(小于10min)、且作业数量较大(大于1000),建议将多个作业合并在一个作业内运行。

如下所示,需要提交1000个不同参数的作业,可以每个作业内跑100个作业,提交10这样的作业:

#BSUB -J process1-100

#BSUB -n 1

#BSUB -R span[hosts=1]

#BSUB -o %J.out

#BSUB -e %J.err

for args in {args1,args2..args100};do

python process.py ${args}

done

合理设置作业内存¶

对于部分程序,因其使用的核数较少、单个作业内存消耗较大,直接批量提交时,容易多个作业被系统分配在一个节点,导致节点内存耗尽、作业被挂起的情况。

跑GWAS流程时所用的一些软件比较频繁出现这种情况,如fastlmmc tassel。因此需要先跑一个作业,结束后查看内存使用(maxmem),如15G,然后批量提交使用lsf参数 -R rusage[mem=15G]来申请内存。

同时不建议盲目申请远远超出实际使用的内存量,如-R rusage[mem=100G],这会导致一个节点只会运行2-3个作业,其它作业也无法使用该节点,造成计算资源大量浪费。

单个作业使用的核心数低于4时,需要及时关注作业运行情况,如果出现大量作业被挂起的情况,使用lsload查看节点内存剩余情况,bjobs -l jobid查看作业内存使用量,使用bmod -R "rusage[mem=15GB] select[maxmem>224800]" jobid调整作业内存消耗,然后brequeue jobid重新运行该作业。

多次出现作业被大面积挂起的情况且没有及时处理,将被降低可使用的核数。

LSF交互作业¶

类似于PBS中的qsub -I,为了防止滥用(开了之后长期不关等)交互模式,目前只允许在interactive队列使用交互模式,且时间限制为48h,超时会被杀掉。

bsub -q interactive -Is bash

也可以

bsub -q interactive -Is sh

此时不会加载~/.bashrc

如果需要进行图形转发,如画图等,可以加-XF 参数

bsub -q interactive -XF -Is bash

查询作业¶

使用bjobs命令查看作业运行状态、所在队列、从哪个节点提交、运行节点及核心数、作业名称、提交时间等。

$ bjobs

JOBID USER STAT QUEUE FROM_HOST EXEC_HOST JOB_NAME SUBMIT_TIME

10498205 username RUN smp login01 10*s001 fq Sep 6 17:54

10498206 username RUN smp login01 10*s001 fq Sep 6 17:54

10498207 username RUN smp login01 10*s001 fq Sep 6 17:54

10498209 username RUN smp login01 10*s001 fq Sep 6 17:54

10498211 username RUN smp login01 10*s001 fq Sep 6 17:54

10498217 username RUN smp login01 10*s001 fq Sep 6 17:54

10498219 username RUN smp login01 10*s001 fq Sep 6 17:54

10498226 username RUN smp login01 10*s001 fq Sep 6 17:54

10498227 username RUN smp login01 10*s001 fq Sep 6 17:54

10498708 username PEND smp login01 fq Sep 6 17:54

10498709 username PEND smp login01 fq Sep 6 17:54

10498710 username PEND smp login01 fq Sep 6 17:54

10498711 username PEND normal login01 fq Sep 6 17:54

10498712 username PEND normal login01 fq Sep 6 17:54

10559750 username USUSP high login02 2*c03n07 GWA Sep 7 14:30

作业状态主要有:

- PEND 正在排队

- RUN 正在运行

- DONE 正常退出

- EXIT 异常退出

- SSUSP 被系统挂起

- USUSP 被用户自己挂起

bjobs还有一些常用的选项,

- -r 查看正在运行的作业

- -pe 查看排队作业

- -l 查看作业详细信息

- -sum 查看所有未完成作业的汇总信息

- -p 查看作业排队的原因,如下面这个作业的排队原因为用户所有正在运行作业所使用的总核心数达到了该用户所能使用核心数上限

其它相关提示如下:

$ bjobs -p 40482594 JOBID USER STAT QUEUE FROM_HOST EXEC_HOST JOB_NAME SUBMIT_TIME 10482594 username PEND normal c01n05 bwa Sep 6 06:33 The user has reached his/her job slot limit (Limit Name: N/A, Limit Value: 1200);User has reached the pre-user job slot limit of the queue

: 用户作业达到了排队中作业所在队列的个人作业核数上限。 : 此队列中用户正在运行的作业有计算结束后,才会再分配后续的排队作业。The slot limit reached;4 hosts: 排队中作业数达到了所在队列可使用节点数的上限。 : 此队列中所有用户正在运行的作业有计算结束,才会再分配此队列中排在最前边的作业。The user has reached his job slot limit: 用于已运行的作业数达到了系统规定的上限。 : 需已运行的作业有新的计算结束,排队中的作业才会进入调度系统。The queue has reached its job slot limit: 排队中已经运行的所有作业达到了系统上队列总作业核数的上限。 : 需该队列中已经运行的作业有新的计算结束,才会调度该队列中排在第一位的作业。Pending job threshold reached. Retrying in 60 seconds: 提交的作业超过系统对用户提交作业数的上限。 : 需该队列中已经运行的作业有新的计算结束,新提交的作业才会被LSF接收。

-

-o 定制输出格式,如为了方便实时查看作业使用的最大内存,添加

max_mem选项,宽度为14。使用$ bjobs -o "jobid:10 user:6 stat:6 queue:6 exec_host:10 job_name:10 max_mem:14 submit_time:12" JOBID USER STAT QUEUE EXEC_HOST JOB_NAME MAX_MEM SUBMIT_TIME 46477783 username RUN high c01n09 AS_TWAS 30.3 Gbytes Dec 12 13:32 46477903 username RUN high c01n09 AS_TWAS 22.6 Gbytes Dec 12 13:32 46477766 username RUN high c01n09 AS_TWAS 20.3 Gbytes Dec 12 13:32 46477725 username RUN high c01n05 AS_TWAS 26.5 Gbytes Dec 12 13:32 46477726 username RUN high c01n05 AS_TWAS 22.7 Gbytes Dec 12 13:32 46477727 username RUN high c01n05 AS_TWAS 19.2 Gbytes Dec 12 13:32 46477804 username RUN high c01n05 AS_TWAS 26.6 Gbytes Dec 12 13:32 46477805 username RUN high c01n05 AS_TWAS 20.3 Gbytes Dec 12 13:32 46477836 username RUN high c01n04 AS_TWAS 25.2 Gbytes Dec 12 13:32alias简写该命令此外也可以添加$ vim ~/.bashrc alias bbjobs='bjobs -o "jobid:10 user:6 stat:6 queue:6 exec_host:10 job_name:10 max_mem:14 submit_time:12"' $ source ~/.bashrc $ bbjobs JOBID USER STAT QUEUE EXEC_HOST JOB_NAME MAX_MEM SUBMIT_TIME 46477783 username RUN high c01n09 AS_TWAS 30.3 Gbytes Dec 12 13:32 46477903 username RUN high c01n09 AS_TWAS 22.6 Gbytes Dec 12 13:32 46477766 username RUN high c01n09 AS_TWAS 20.3 Gbytes Dec 12 13:32 46477725 username RUN high c01n05 AS_TWAS 26.5 Gbytes Dec 12 13:32 46477726 username RUN high c01n05 AS_TWAS 22.7 Gbytes Dec 12 13:32 46477727 username RUN high c01n05 AS_TWAS 19.2 Gbytes Dec 12 13:32 46477804 username RUN high c01n05 AS_TWAS 26.6 Gbytes Dec 12 13:32 46477805 username RUN high c01n05 AS_TWAS 20.3 Gbytes Dec 12 13:32 46477836 username RUN high c01n04 AS_TWAS 25.2 Gbytes Dec 12 13:32run_timecpu_used查询作业的 runtime (作业运行的时间)和 cputime (作业运行消耗的CPU时)。一般而言,cputime ≈ runtime*核数,若 cputime 远小于 runtime,则表示作业资源申请不合理,或作业在空跑,请检查作业是否正常在跑。 如下所示,作业 cputime 远小于 runtime,经检查作业运行出错,但没有退出。alias bbs='bjobs -o "jobid:8 user:8 stat:6 queue:6 exec_host:10 job_name:8 nreq_slot:6 slots:5 max_mem:12 submit_time:12 start_time:12 run_time:16 cpu_used"'# bjobs -o "jobid:8 user:8 stat:6 queue:6 exec_host:10 job_name:8 nreq_slot:6 slots:5 max_mem:12 submit_time:12 start_time:12 run_time:16 cpu_used" $ bbs JOBID USER STAT QUEUE EXEC_HOST JOB_NAME NREQ_S SLOTS MAX_MEM SUBMIT_TIME START_TIME RUN_TIME CPU_USED 6554018 username RUN normal 8*c03n02 *g_BK200 8 8 520 Mbytes Sep 13 15:38 Sep 13 20:28 48509 second(s) 3285 second(s) 6554039 username RUN normal 8*c03n06 *g_BR461 8 8 473 Mbytes Sep 13 15:38 Sep 13 21:18 45488 second(s) 4043 second(s) 6554029 username RUN normal 8*c03n09 *g_BL300 8 8 517 Mbytes Sep 13 15:38 Sep 13 21:09 46049 second(s) 4067 second(s) 6554015 username RUN normal 8*c01n05 *_BJS500 8 8 516 Mbytes Sep 13 15:38 Sep 13 20:20 48979 second(s) 3222 second(s) 6554021 username RUN normal 8*c02n09 *g_BK350 8 8 482 Mbytes Sep 13 15:38 Sep 13 20:32 48232 second(s) 2963 second(s) 6554022 username RUN normal 8*c02n08 *g_BK400 8 8 699 Mbytes Sep 13 15:38 Sep 13 20:37 47988 second(s) 3952 second(s) 6554028 username RUN normal 8*c03n01 *g_BL250 8 8 539 Mbytes Sep 13 15:38 Sep 13 21:03 46410 second(s) 3755 second(s) 6554024 username RUN normal 8*c04n03 *g_BK500 8 8 515 Mbytes Sep 13 15:38 Sep 13 20:38 47873 second(s) 3867 second(s) 6554044 username RUN normal 8*c01n13 *g_BS400 8 8 507 Mbytes Sep 13 15:38 Sep 13 21:23 45191 second(s) 2018 second(s) 6554043 username RUN normal 8*c01n02 *g_BS300 8 8 593 Mbytes Sep 13 15:38 Sep 13 21:23 45221 second(s) 3394 second(s) 6554046 username RUN normal 8*c02n10 *g_BS500 8 8 534 Mbytes Sep 13 15:38 Sep 13 21:28 44888 second(s) 3262 second(s)

修改排队作业运行参数¶

bmod可更改正在排队的作业的多个参数,如

bmod -n 2 jobid 更改作业申请的核心数

bmod -q q2680v2 jobid 更改作业运行队列

挂起/恢复作业¶

用户可自行挂起或者继续运行被挂起的作业。

bstop jobid 挂起作业,如作业被系统挂起(节点剩余可用内存过低系统会自动挂起该节点上的部分作业),则作业状态为SSUSP;如被用户自己或管理员挂起,则作业状态为USUSP

bresume bjoid 继续运行被挂起的作业

因为作业在挂起时,仍然会占用计算资源,因此用户不可自己随意长时间大批量挂起自己的作业以避免资源浪费。

调整排队作业顺序¶

bbot jobid 将排队的作业移动到队列最后(bottom)

btop jobid 将排队的作业移动到队列最前(top)

查询输出文件¶

在作业完成之前,输出文件out和error被保存在系统文件中无法查看,可以使用bpeek命令查看输出文件

终止作业¶

如果用户要在作业提交后终止自己的作业,可以使用bkill命令,用法为bkill jobid。非root用户只能查看、删除自己提交的作业。

bkill 12345 杀死作业id为12345的作业

bkill 0 杀死当前用户的所有作业(正在运行的、排队的、挂起的等)

资源查看¶

bhosts¶

查看所有节点核心数使用情况

$ bhosts

HOST_NAME STATUS JL/U MAX NJOBS RUN SSUSP USUSP RSV

c01n01 closed - 36 36 36 0 0 0

c01n02 closed - 36 36 36 0 0 0

c01n03 closed - 36 36 36 0 0 0

c01n04 closed - 36 36 36 0 0 0

c01n05 closed - 36 36 36 0 0 0

c07n09 closed - 36 36 36 0 0 0

c07n10 closed - 36 36 36 0 0 0

c07n11 closed - 36 36 36 0 0 0

gpu01 ok - 36 29 29 0 0 0

gpu02 ok - 20 0 0 0 0 0

login01 closed - 0 0 0 0 0 0

login02 closed - 0 0 0 0 0 0

login03 closed - 0 0 0 0 0 0

mn02 closed - 0 0 0 0 0 0

mn02 closed - 0 0 0 0 0 0

s001 closed - 192 192 192 0 0 0

s002 closed - 192 192 192 0 0 0

s003 ok - 192 189 189 0 0 0

sg01 closed - 20 20 20 0 0 0

sg02 closed - 20 20 20 0 0 0

sg03 closed - 20 20 20 0 0 0

sg04 closed - 20 20 20 0 0 0

sg05 closed - 20 20 20 0 0 0

sg06 ok - 20 0 0 0 0 0

sg07 closed - 20 20 20 0 0 0

sg08 closed - 20 20 20 0 0 0

sg09 ok - 20 0 0 0 0 0

sg10 ok - 20 17 17 0 0 0

- HOST_NAME 节点名称

- STATUS: ok:表示可以接收新作业,只有这种状态可以接受新作业 closed:表示已被作业占满,不接受新作业 unavail和unreach:系统停机或作业调度系统服务有问题

- JL/U 每个用户在该节点最多能使用的核数,- 表示没有限制

- MAX 最大可以同时运行的核数

- NJOBS 当前所有运行和待运行作业所需的核数

- RUN 已经开始运行的作业占据的核数

- SSUSP 系统所挂起的作业所使用的核数

- USUSP 用户自行挂起的作业所使用的核数

- RSV 系统为你预约所保留的核数

lsload¶

查看所有节点的负载、内存使用等

$ lsload

HOST_NAME status r15s r1m r15m ut pg ls it tmp swp mem

sg17 ok 0.0 0.0 0.1 0% 0.0 0 2e+5 264G 2.4G 113G

sg11 ok 0.0 0.0 0.1 0% 0.0 0 49055 264G 3.7G 113G

gpu02 ok 0.0 0.0 0.1 0% 0.0 0 7337 248G 29.8G 52.9G

login01 ok 0.2 0.7 0.6 6% 0.0 39 0 242G 0M 47.6G

login02 ok 0.7 0.4 0.6 5% 0.0 41 0 241G 27.8G 42.9G

sg27 ok 0.8 0.6 0.6 4% 0.0 0 88098 264G 3G 110G

c01n11 ok 0.8 19.7 19.6 4% 0.0 0 1788 432G 2.1G 348G

c05n07 ok 1.0 1.0 1.0 3% 0.0 0 1463 429G 3G 170G

c07n09 ok 1.0 1.0 1.0 3% 0.0 0 14604 432G 3.9G 158G

c01n10 ok 1.1 18.7 18.7 3% 0.0 0 3713 432G 3G 349G

sg21 ok 1.2 1.2 1.2 7% 0.0 0 5054 258G 3.6G 109G

c03n07 ok 1.3 18.6 18.6 4% 0.0 0 15072 429G 3.1G 340G

sg30 ok 1.3 1.0 1.0 5% 0.0 0 734 265G 2.4G 69.6G

c01n06 ok 1.3 20.0 20.6 5% 0.0 0 13242 432G 3.7G 351G

sg25 ok 1.5 1.0 1.7 5% 0.0 0 2e+5 258G 2.1G 108G

c06n03 ok 1.6 13.3 13.4 9% 0.0 0 14576 432G 3.7G 168G

sg02 ok 1.8 54.3 45.7 9% 0.0 2 18 239G 63.9M 78.5G

c06n01 ok 1.9 7.7 7.6 5% 0.0 0 3718 432G 3.8G 167G

c07n06 ok 2.0 14.3 14.2 12% 0.0 0 14956 431G 3.8G 166G

c05n05 ok 35.6 35.5 33.8 96% 0.0 0 15103 426G 2.9G 119G

c04n05 ok 35.7 35.8 35.4 94% 0.0 0 15972 427G 2.8G 114G

c06n06 ok 36.0 36.0 36.1 100% 0.0 0 14658 432G 3.7G 173G

c05n01 ok 37.4 38.3 37.5 97% 3.7 0 12160 432G 1.4G 141G

c06n12 ok 39.4 36.8 34.2 94% 0.0 0 7495 430G 3.6G 132G

c01n12 ok 45.1 48.2 46.8 82% 0.0 0 8000 432G 1.7G 278G

s002 ok 61.0 61.5 57.6 31% 0.0 1 739 1309G 3.1G 1.5T

s001 ok 70.9 73.7 91.8 19% 0.0 0 740 1286G 42.8M 1.3T

s006 ok 124.6 128.4 132.1 100% 0.0 0 432 1101G 3.5G 1.9T

s004 ok 128.1 125.3 123.3 65% 0.0 0 758 1318G 429M 1.8T

s003 ok 244.5 235.9 240.7 98% 0.0 1 3 1288G 2.8G 1.6T

bqueues¶

查看队列信息

$ bqueues

QUEUE_NAME PRIO STATUS MAX JL/U JL/P JL/H NJOBS PEND RUN SUSP

interactive 80 Open:Active - 3 - - 81 1 74 6

normal 30 Open:Active - - - - 19012 15984 3028 0

parallel 30 Open:Active - - - - 725 500 225 0

gpu 30 Open:Active - 10 - - 37 8 29 0

high 30 Open:Active - - - - 349 182 166 1

smp 30 Open:Active - 300 - - 6106 5166 940 0

q2680v2 30 Open:Active - 100 - - 5330 4784 546 0

- -u 查看所用所能使用的队列

- -m 查看节点所在的队列

- -l 查看队列的详细信息

$ bqueues -l smp QUEUE: smp -- huge memory jobs PARAMETERS/STATISTICS PRIO NICE STATUS MAX JL/U JL/P JL/H NJOBS PEND RUN SSUSP USUSP RSV PJOBS 30 0 Open:Active - 300 - - 6106 5156 950 0 0 0 737 Interval for a host to accept two jobs is 0 seconds HOSTLIMIT_PER_JOB 1 SCHEDULING PARAMETERS r15s r1m r15m ut pg io ls it tmp swp mem loadSched - - - - - - - - - - 29.2G loadStop - - - - - - - - - - 9.7G SCHEDULING POLICIES: NO_INTERACTIVE USERS: all HOSTS: s001 s002 s003 s004 s005 s006 RES_REQ: rusage[mem=10000] span[hosts=1] RESRSV_LIMIT: [mem=2000000] RERUNNABLE : yes

常见问题¶

- 程序运行异常但没有作业没有退出,最常见于 hisat2 比对,使用 bpeek 查看作业日志,报错如下

(ERR): "/public/home/username/database/reference/genome" does not exist Exiting now ...

帐号申请¶

用户范围¶

本系统实行收费使用的管理办法,面向全校师生开放使用。

帐号申请时间¶

本集群每学期初和学期中(第12周左右)开放一次申请、考核,具体的通知会发到超算网站(hpc.hzau.edu.cn)、超算用户QQ群、公众号(作物遗传改良卓越工程师工作室)等处。由于各种原因错过每学期帐号申请的同学,需等到下次开放申请。

帐号申请流程¶

- 学期初或12周左右,管理员下发集群开放申请通知,并开放集群考核报名的在线文档,如果有需要可填写报名文档参加考核。时间约为一周,期间练习账号也会开放,可向管理员申请使用。

- 申请用户参加集群用户考核,考核形式为纸质试卷+上机测试,考核内容见 集群考试内容。考试为开卷考试,可以携带学习资料、使用机房电脑搜索查询等。

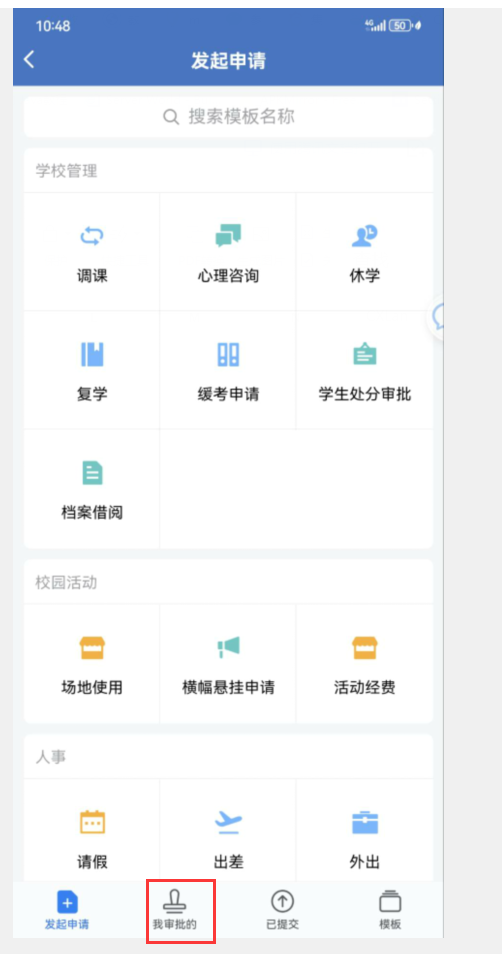

- 考核80分通过,通过的申请用户需在企业微信上提交

超算账号申请审批单,审批人为导师。 - 管理员开通集群帐号,并将相关信息发到申请用户邮箱。

使用企业微信提请账号审批流程¶

如果没有加入“华中农大微校园”企业微信,可以按链接中的指南加入,企业微信加入指南

通过企微提请一个新集群账号申请的审批单,审批人为导师,

审批的位置:打开企微app->工作台->审批

导师审批的位置:工作台->审批->我的审批

集群采用NIS用户认证,如用户需要修改密码,只需在登陆节点运行yppasswd,根据提示输入旧密码,然后输入新密码即可。新密码需要遵循以下规则,否则无法修改成功:

- 新密码长度至少包含 10 个字符

- 新密码至少包含1个数字

- 新密码至少包含1大写字母

- 新密码至少包含1个特殊字符

- 新密码至少包含1个小写字母

作业队列划分¶

根据硬件配置和功能划分需要,集群划分为6个作业队列,normal、high、interactive、parrallel、smp、q2680v2和gpu,默认6个队列所对应的计算节点和使用限制如下。在集群实际运行过程中可能会根据使用情况有所调整,用户可以使用bquque命令查看每个作业队列的使用情况。

- normal、high队列单个作业申请的CPU数不超过36核;q2680v2队列申请的CPU核数不超过20核;smp队列申请的核数不超过100核;

- normal队列作业每核内存不超过5G,否则会被系统杀掉;作业如需较多内存,则需申请多个核;high队列每核内存限制为10G;

- 运行perl、python、R等脚本,如果使用内存较少,建议只申请1核;

- 集群作业较多、排队时间较长时,请注意减少作业申请核数或使用q2680v2队列,以避免排队时间过长;

| 队列 | 节点 | 使用限制 | 功能说明 |

|---|---|---|---|

| normal | c01n01-c07n11 | 作业平均每核内存不超过5G,否则会被系统杀掉(TERM_MEMLIMIT: job killed after reaching LSF memory usage limit);作业需要较多的内存,则需要申请更多核,如预计作业会用到20G内存,则至少申请4核 | 集群默认队列 |

| high | c01n01-c04n03 | 作业平均每核内存不超过10G,否则会被系统杀掉(TERM_MEMLIMIT: job killed after reaching LSF memory usage limit);作业需要较多的内存,则需要申请更多核,如预计作业会用到50G内存,则至少申请5核 | 每节点内存384GB |

| interactive | sg57-sg60 | 2核/用户,24h | 交互作业队列,用于调试代码或画图等 |

| parrallel | c01n01-c07n11 | 100核/用户,使用需向管理员申请 | 并行作业队列,运行MPI作业,如maker |

| smp | s001-s006 | 100 核/节点/用户;作业平均每核内存不超过10G,否则会被系统杀掉(TERM_MEMLIMIT: job killed after reaching LSF memory usage limit);作业需要较多的内存,则需要申请更多核,如预计作业会用到200G内存,则至少申请20核 | 胖节点队列,节点内存2T-4T,建议作业内存200G使用此队列 |

| gpu | gpu01-02 | 使用需向管理员申请 | GPU作业可申请使用,见GPU节点使用 |

| q2680v2 | sg01-sg60 | 100核/用户 | 老集群队列,速度相对较慢 |

备份存储使用¶

Warning

因备份存储早已过了保修期,且故障率非常高,现已不再往备份存储内存放数据。

为了提高系统并行存储的利用率和节省大家服务器存储使用费用,大家可以把服务器上使用频率较少的重要数据存放在服务器的备份存储上,具体使用方法如下,

- 向管理员申请使用备份存储,然后管理员会在备份存储节点上建立相应的目录,并赋予相应的权限

- 登录login02节点,将并行存储中的数据转移到备份存储上,如username用户在份存储上的数据目录为

/backup/data/username - 严禁在备份存储上直接跑作业

- 大的文本文件如fastq、fasta、sam、vcf等,务必先压缩后再备份到备份存储上,以节省备份存储的磁盘空间

- 如果一次备份的数据量较大,建议先使用rsync将数据同步到备份存储,如

rsync -av --progress /public/home/username/data /backup/data/username,确认完全同步完之后,再将源数据删除

账户注销¶

在学期结束后,已毕业不再使用集群的用户,需备份下载自己需要保留的数据,然后将账号内的数据清空,以免产生不必要的存储费用。管理员择时统一注销所有账号。注销账号前会再跟本人或导师进行确认。

考试内容¶

服务器考试范围大致分为三块:

- Linux基本使用

- LSF作业提交系统的使用

- 集群使用规章制度和注意事项

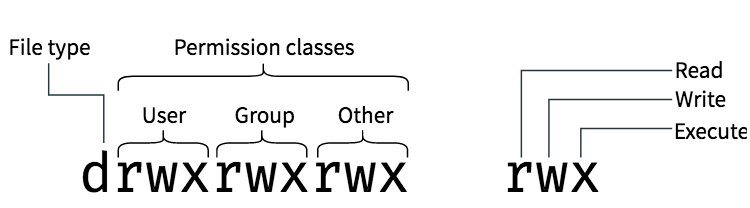

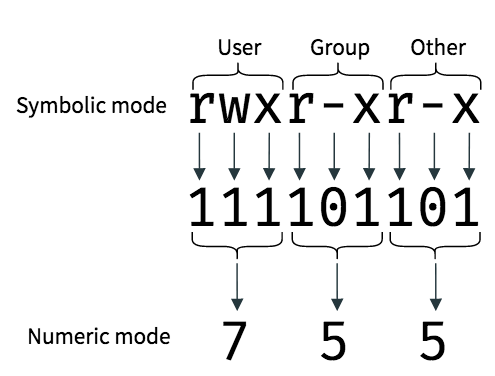

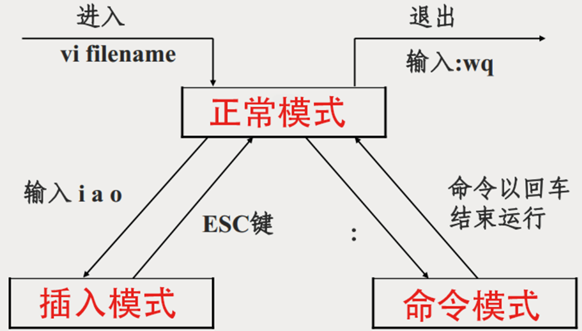

Linux基本使用¶

- 文件目录操作,要求掌握文件所属的用户和用户组、文件权限的概念(可读、可写、可执行),理解不同的文件类型,如普通文件、目录、块设备、链接文件等,要求掌握的命令

ls、pwd、cd、mv、rm、mkdir、ln、cp、chmod、alias; - 文本操作,需要掌握至少一种文本编辑器(推荐vim),理解管道、重定向,要求掌握基本的文本处理命令

cat、more、less、head、tail、wc、nl、cut、sort、uniq、grep、sed、awk、file; - 查看系统信息,能使用Linux系统提供的工具和命令查看磁盘使用、系统负载、内存使用、系统版本等信息,需要掌握的命令

df、du、free、uptime; - 进程管理,了解进程和多线程的基本概念,需要掌握的命令

top、ps、bg、fg、jobs、kill、pgrep、nohup、screen、Ctrl+z、Ctrl+c; - 掌握Linux软件的安装,主要是能从源码编译安装二进制文件,理解PATH变量,编辑

~/.bashrc文件,使用rpm -qa命令查看系统安装的一些库和软件; - 简单的Linux shellscprit编程知识,掌握基本的语法;

- 其他,文件查找

which、locate、find、where,文件压缩tar、gzip、pigz,查看帮助文档man,远程文件传输scp rsync,不同节点间跳转ssh,查看已使用的命令history,查看当前登陆用户who,文件下载wget,windows文件转Unix文件dos2unix。

linux学习可以参考:Linux 基础

LSF作业提交系统的使用¶

集群使用规章制度和注意事项¶

收费标准¶

每个CPU时0.1元,并行存储空间每GB每月0.05元。

折扣标准¶

重点室用户3折;重点实验室之外的用户不打折。

文章机时折扣¶

根据用户上报的上一年度的文章,决定本年度的集群机时折扣。

论文致谢模板¶

中文: 本论文的计算结果得到了华中农业大学作物遗传改良全国重点实验室生物信息计算平台的支持和帮助。

English: The computations in this paper were run on the bioinformatics computing platform of the National Key Laboratory of Crop Genetic Improvement, Huazhong Agricultural University.

新闻稿致谢: 该研究数据分析工作得到华中农业大学作物遗传改良全国重点实验室生物信息计算平台的支持和帮助。

致谢文章列表¶

点击表头可以将表格重新排序

| 年份 | 文章 | 期刊 | 期刊分级 |

|---|---|---|---|

| 2026.01 | Genomic basis underlying alternative transcripts-mediated drought tolerance in maize | Genome Biology | A |

| 年份 | 文章 | 期刊 | 期刊分级 |

|---|---|---|---|

| 2025.01 | Two rice cultivars recruit different rhizospheric bacteria to promote aboveground regrowth after mechanical defoliation | Microbiology Spectrum | |

| 2025.01 | Feedback regulation of m6A modification creates local auxin maxima essential for rice microsporogenesis | Developmental Cell | B |

| 2025.01 | A wheat phytohormone atlas spanning major tissues across the entire life cycle provides novel insights into cytokinin and jasmonic acid interplay | Molecular Plant | B |

| 2025.01 | An epiallele of a gene encoding a PfkB-type carbohydrate kinase affects plant architecture in maize | Plant Cell | B |

| 2025.01 | Global Protein Interactome Mapping in Rice Using Barcode-Indexed PCR Coupled with HiFi Long-Read Sequencing | Advanced Science | A |

| 2025.01 | CSGDN: contrastive signed graph diffusion network for predicting crop gene–phenotype associations | Briefings in Bioinformatics | B |

| 2025.01 | AMIR: a multi-omics data platform for Asteraceae plants genetics and breeding research | Nucleic Acids Research | B |

| 2025.02 | Simultaneous profiling of chromatin-associated RNA at targeted DNA loci and RNA-RNA Interactions through TaDRIM-seq | Nature Communications | B |

| 2025.03 | Precise engineering of gene expression by editing plasticity | Genome Biology | A |

| 2025.03 | Widespread impact of transposable elements on the evolution of post-transcriptional regulation in the cotton genus Gossypium | Genome Biology | A |

| 2025.03 | RAPID LEAF FALLING 1 facilitates chemical defoliation and mechanical harvesting in cotton | Molecular Plant | B |

| 2025.03 | The haplotype-resolved genome assembly of an ancient citrus variety provides insights into the domestication history and fruit trait formation of loose-skin mandarins | Genome Biology | A |

| 2025.03 | GWAS and eQTL analyses reveal genetic components influencing the key fiber yield trait lint percentage inupland cotton | The Plant Journal | C |

| 2025.03 | Precise engineering of gene expression by editing plasticity | Genome Biology | A |

| 2025.04 | Integrative omics analysis reveals the genetic basis of fatty acid composition in Brassica napus seeds | Genome Biology | A |

| 2025.04 | RAPID LEAF FALLING 1 facilitates chemical defoliation and mechanical harvesting in cotton | Molecular Plant | B |

| 2025.04 | A panoramic view of cotton resistance to Verticillium dahliae: From genetic architectures to precision genomic selection | iMeta | |

| 2025.04 | Gossypium latifolium genome reveals the genetic basis of domestication of upland cotton from semi-wild races to cultivars | The Crop Journal | C |

| 2025.04 | DNA methylation dynamics play crucial roles in shaping the distinct transcriptomic profiles for different root-type initiation in rice | Genome Biology | A |

| 2025.04 | Continuous infiltration and evolutionary trajectory of nuclear organelle DNA in Oryza | Genome Biology | A |

| 2025.04 | Genetic and transcriptome analyses of the effect of genotype-by-environment interactions on Brassica napus seed oil content | The Plant Cell | B |

| 2025.05 | Pangenome analysis reveals yield- and fiber-related diversity and interspecific gene flow in Gossypium barbadense L. | Nature Communications | B |

| 2025.05 | Pangenome analysis reveals yield- and fiber-related diversity and interspecific gene flow in Gossypium barbadense L. | Nature Communications | B |

| 2025.05 | Comprehensive multi-omics analysis of nutrient dynamics in colored wheat provides novel insights into the development of functional foods | Seed Biology | |

| 2025.06 | DNA demethylase augments RNA-directed DNA methylation by enhancing CLSY gene expression in maize and Arabidopsis | Molecular Plant | B |

| 2025.06 | Chromatin accessibility dynamics and transcriptional regulatory networks underlying the primary nitrogen response in rice roots | Plant Communications | |

| 2025.07 | Genome assembly of two allotetraploid cotton germplasms reveals mechanisms of somatic embryogenesis and enables precise genome editing | Nature Genetics | A |

| 2025.07 | DNA demethylase augments RNA-directed DNA methylation by enhancing CLSY gene expression in maize and Arabidopsis | Molecular Plant | B |

| 2025.08 | Microrchidia ATPases and DNA 6mA demethylase ALKBH1 act antagonistically on PRC2 to control chromatin structure and stress tolerance | Nature Plants | B |

| 2025.08 | Enhancing signed graph neural networks through curriculum-based training | Neural Networks | C |

| 2025.08 | Characterisation of Early Biosynthetic Steps of Atractylon via an Integrative Strategy | Plant Biotechnology Journal | |

| 2025.09 | A cluster of four papain-like cysteine proteases is specifically induced by commensal bacteria and modulates the bacterial load in rice | International Journal of Biological Macromolecules | C |

| 2025.09 | High-resolution time-series transcriptomic and metabolomic profiling reveals the regulatory mechanism underlying salt tolerance in maize | Genome Biology | A |

| 2025.09 | Adaptation of centromeres to breakage through local genomic and epigenomic remodeling in wheat | Genome Research | B |

| 2025.09 | Distinct evolutionary trajectories of subgenomic centromeres in polyploid wheat | Genome Biology | A |

| 2025.10 | cfMethDB: A Comprehensive cfDNA Methylation Data Resource for Cancer Biomarkers | Genomics, Proteomics & Bioinformatics | |

| 2025.11 | Optimizing thiamine pyrophosphate metabolism enhances crop yield and quality | Nature Communications | B |

| 2025.11 | Integrative multi-omics analysis reveals the domestication mechanism of black rice | National Science Review | A |

| 2025.11 | ricePSP: a database of rice phase separation-associated proteins | Genome Biology | A |

| 2025.11 | ADA2 forms nuclear condensates with GCN5 and ATP-citrate lyase (ACL) to modulate H3K9 acetylation at genes functioning in rice meristems | Advanced Science | A |

| 2025.11 | Genetic basis of flavor complexity in sweet corn | Nature Genetics | A |

| 2025.11 | Optimizing thiamine pyrophosphate metabolism enhances crop yield and quality | Nature Communications | B |

| 2025.12 | Genetic control of seasonal meristem arrest in trees | PNAS | A |

| 2025.12 | Cultivar‐specific preference of bacterial communities and host immune receptor kinase modulate the outcomes of rice-microbiota interactions | iMeta | |

| 2025.12 | Genetic diversity and architectural dynamics of soybean centromeres | Genome Biology | A |

| 2025.12 | Telomere-to-telomere genome assembly reveals the genomic architecture of disease resistance and yield coordination in elite wheat YM33 | Molecular Plant | B |

| 2025.12 | Evolutionary innovations and genetic diversity in angiosperm centromeres | Molecular Plant | B |

| 年份 | 文章 | 期刊 | 期刊分级 |

|---|---|---|---|

| 2024.01 | Synergistic interplay of redox homeostasis and polysaccharide synthesis promotes cotton fiber elongation | Plant Journal | |

| 2024.01 | Dynamic metabolic-QTL analyses provide novel biochemical insights into the kernel development and nutritional quality improvement in common wheat | Plant Communications | |

| 2024.01 | KLF4 facilitates chromatin accessibility remodeling in porcine early embryos | SCIENCE CHINA Life Sciences | |

| 2024.02 | Lysine acetylation of histone acetyltransferase adaptor protein ADA2 is a mechanism of metabolic control of chromatin modification in plants | Nature Plants | B |

| 2024.02 | Precise fine-turning of GhTFL1 by base editing tools defines ideal cotton plant architecture | Genome Biology | A |

| 2024.02 | Beyond pathways: accelerated flavonoids candidate identification and novel exploration of enzymatic properties using combined mapping populations of wheat | Plant Biotechnology Journal | |

| 2024.03 | Three near-complete genome assemblies reveal substantial centromere dynamics from diploid to tetraploid in Brachypodium genus | Genome Biology | A |

| 2024.03 | Constructing the metabolic network of wheat kernels based on structure-guided chemical modification and multi-omics data | Journal of Genetics and Genomics | |

| 2024.03 | Dissecting the molecular basis of spike traits by integrating gene regulatory network and genetic variation in wheat | Plant Communications | |

| 2024.03 | A double-stranded RNA binding protein enhances drought resistance via protein phase separation in rice | Nature Communications | B |

| 2024.04 | DNA methylation remodeling and the functional implication during male gametogenesis in rice | Genome Biology | A |

| 2024.04 | A comprehensive benchmark of graph-based genetic variant genotyping algorithms on plant genomes for creating an accurate ensemble pipeline | Genome Biology | A |

| 2024.05 | The Genetic Basis and Process of Inbreeding Depression in an Elite Hybrid Rice | Science China Life Sciences | |

| 2024.05 | A spatial transcriptome map of the developing maize ear | Nature Plants | B |

| 2024.06 | Progressive meristem and single-cell transcriptomes reveal the regulatory mechanisms underlying maize inflorescence development and sex differentiation | Molecular Plant | B |

| 2024.06 | Powerful QTL mapping and favorable allele mining in an all-in-one population: a case study of heading date | National Science Review | A |

| 2024.06 | LEUTX regulates porcine embryonic genome activation in somatic cell nuclear transfer embryos | Cell Reports | B |

| 2024.06 | Characterization of the DNA accessibility of chloroplast genomes in grasses | Communications Biology | |

| 2024.07 | Dissecting the Superior Drivers for the Simultaneous Improvement of Fiber Quality and Yield under Drought Stress Via Genome-Wide Artificial Introgressions of Gossypium barbadense into Gossypium hirsutum | Advanced Science | A |

| 2024.07 | Stress-induced nuclear translocation of ONAC023 improves drought and heat tolerance through multiple processes in rice | Nature Communications | B |

| 2024.08 | The OsSRO1c-OsDREB2B complex undergoes protein phase transition to enhance cold tolerance in rice | Molecular Plant | B |

| 2024.08 | aChIP is an efficient and sensitive ChIP-seq technique for economically important plant organs | Nature Plants | B |

| 2024.08 | Genetic regulatory perturbation of gene expression impacted by genomic introgression in fiber development of allotetraploid cotton | Advanced Science | A |

| 2024.09 | A dynamic regulome of shoot-apical-meristem-related homeobox transcription factors modulates plant architecture in maize | Genome Biology | A |

| 2024.09 | A truncated B-box zinc finger transcription factor confers drought sensitivity in modern cultivated tomatoes | Nature Communications | B |

| 2024.09 | Chromosome-scale and haplotype-resolved genome assembly of the autotetraploid Misgurnus anguillicaudatus | Scientific data | |

| 2024.10 | Drought-responsive dynamics of H3K9ac-marked 3D chromatin interactions are integrated by OsbZIP23-associated super-enhancer-like promoter regions in rice | Genome Biology | A |

| 2024.10 | AMIR: a multi-omics data platform for Asteraceae plants genetics and breeding research | Nucleic Acids Research | B |

| 2024.10 | Simultaneous Profiling of Chromatin-Associated RNA at Targeted DNA Loci and RNA-RNA Interactions through TaDRIM-Seq | Nature Communications | B |

| 2024.10 | The loach haplotype-resolved genome and the identification of Mex3a involved in fish air breathing | Cell genomics | |

| 2024.10 | TRANSPARENT TESTA 16 collaborates with the MYB-bHLH-WD40 transcriptional complex to produce brown fiber cotton | Plant Physiology | |

| 2024.10 | Convergence and divergence of diploid and tetraploid cotton genomes | Nature Genetics | A |

| 2024.10 | Redefining the accumulated temperature index for accurate prediction of rice flowering time in diverse environments | Plant Biotechnology Journal | |

| 2024.11 | Dynamic atlas of histone modifications and gene regulatory networks in endosperm of bread wheat | Nature Communications | B |

| 2024.12 | The transcription factor CCT30 promotes rice preharvest sprouting by regulating sugar signalling to inhibit the ABA-mediated pathway | Plant Biotechnology Journal | |

| 2024.12 | Systemic evaluation of various CRISPR/Cas13 orthologs for knockdown of targeted transcripts in plants | Genome Biology | A |

| 2024.12 | Chromatin loops gather targets of upstream regulators together for efficient gene transcription regulation during vernalization in wheat | Genome Biology | A |

| 2024.12 | Epigenomic and 3D genomic mapping reveals developmental dynamics and subgenomic asymmetry of transcriptional regulatory architecture in allotetraploid cotton | Nature Communications | B |

| 年份 | 文章 | 期刊 | 期刊分级 |

|---|---|---|---|

| 2023.06 | Genome editing of a rice CDP-DAG synthase confers multipathogen resistance | Nature | A+ |

| 2023.12 | Two teosintes made modern maize | Science | A+ |

| 2023.03 | A translatome-transcriptome multi-omics gene regulatory network reveals the complicated functional landscape of maize | Genome Biology | A |

| 2023.04 | Asymmetric gene expression and cell-type-specific regulatory networks in the root of bread wheat revealed by single-cell multiomics analysis | Genome Biology | A |

| 2023.08 | 3D organization of regulatory elements for transcriptional regulation in Arabidopsis | Genome Biology | A |

| 2023.08 | Single-cell resolution analysis reveals the preparation for reprogramming the fate of the plant stem cell niche in lateral meristems | Genome Biology | A |

| 2023.08 | A DNA adenine demethylase impairs PRC2-mediated repression of genes marked by a specific chromatin signature | Genome Biology | A |

| 2023.08 | Suppressing a phosphohydrolase of cytokinin nucleotide enhances grain yield in rice | Nature Genetics | A |

| 2023.10 | Regulatory controls of duplicated gene expression during fiber development in allotetraploid cotton | Nature Genetics | A |

| 2023.08 | Spontaneous movement of a retrotransposon generated genic dominant male sterility providing a useful tool for rice breeding | National Science Review | A |

| 2023.11 | Single-Cell Transcriptome Atlas and Regulatory Dynamics in Developing Cotton Anthers | Advanced Science | A |

| 2023.11 | Age-dependent seasonal growth cessation in Populus | PNAS | A |

| 2023.05 | Haplotype mapping of H3K27me3-associated chromatin interactions defines topological regulation of gene silencing in rice | Cell Reports | B |

| 2023.09 | DELLA-mediated gene repression is maintained by chromatin modification in rice | EMBO Journal | B |

| 2023.08 | Centromere plasticity with evolutionary conservation and divergence uncovered by wheat 10+ genomes | Molecular Biology and Evolution | B |

| 2023.02 | A minimal genome design to maximally guarantee fertile inter-subspecific hybrid rice | Molecular Plant | B |

| 2023.03 | Rice Gene Index: A comprehensive pan-genome database for comparative and functional genomics of Asian rice | Molecular Plant | B |

| 2023.03 | BnIR: A multi-omics database with various tools for Brassica napus research and breeding | Molecular Plant | B |

| 2023.08 | MaizeNetome: A multi-omics network database for functional genomics in maize | Molecular Plant | B |

| 2023.10 | Control of rice ratooning ability by a nucleoredoxin that inhibits histidine kinase dimerization to attenuate cytokinin signaling in axillary bud growth | Molecular Plant | B |

| 2023.08 | Integrated 3D Genome, Epigenome, and Transcriptome Analyses Reveal Transcriptional Coordination of Circadian Rhythm in Rice | Nucleic Acids Research | B |

| 2023.10 | SoyMD: a platform combining multi-omics data with various tools for soybean research and breeding | Nucleic Acids Research | B |

| 2023.10 | PMhub 1.0: a comprehensive plant metabolome database | Nucleic Acids Research | B |

| 2023.10 | MethMarkerDB: a comprehensive cancer DNA methylation biomarker database | Nucleic Acids Research | B |

| 2023.03 | Pan-genome inversion index reveals evolutionary insights into the subpopulation structure of Asian rice | Nature Communications | B |

| 2023.08 | QTG-Miner aids rapid dissection of the genetic base of tassel branch number in maize | Nature Communications | B |

| 2023.10 | Paternal DNA methylation is remodeled to maternal levels in rice zygote | Nature Communications | B |

| 2023.11 | Transcriptome-wide association analyses reveal the impact of regulatory variants on rice panicle architecture and causal gene regulatory networks | Nature Communications | B |

| 2023.06 | Serine protease NAL1 exerts pleiotropic functions through degradation of TOPLESS-related corepressor in rice | Nature Plants | B |

| 2023.11 | Chemical-tag-based semi-annotated metabolomics facilitates gene identification and specialized metabolic pathway elucidation in wheat | Plant Cell | B |

| 2023.04 | Identification of sex-linked codominant markers and development of a rapid LAMP-based genetic sex identification method in channel catfish (Ictalurus punctatus) | Aquaculture | |

| 2023.12 | Comparative Mitogenome Analyses Uncover Mitogenome Features and Phylogenetic Implications of the Reef Fish Family | Biology (Basel) | |

| 2023.09 | The chromosome-scale reference genome of mirid bugs (Adelphocoris suturalis) genome provides insights into omnivory, insecticide resistance, and survival adaptation | BMC Biology | |

| 2023.03 | RNA binding proteins are potential novel biomarkers of egg quality in yellow catfish | BMC Genomics | |

| 2023.03 | The genomic characteristics affect phenotypic diversity from the perspective of genetic improvement of economic traits | iScience | |

| 2023.03 | ZmHOX32 is related to photosynthesis and likely functions in plant architecture of maize | Frontiers in Plant Science | |

| 2023.02 | A heavy metal transporter gene ZmHMA3a promises safe agricultural production on cadmium-polluted arable land | Journal of Genetics and Genomics | |

| 2023.05 | Revealing the process of storage protein rebalancing in high quality protein maize by proteomic and transcriptomic | Journal of Integrative Agriculture | |

| 2023.02 | ArecaceaeMDB: a comprehensive multi-omics database for Arecaceae breeding and functional genomics studies | Plant Biotechnology Journal | |

| 2023.04 | Domains Rearranged Methylase 2 maintains DNA methylation at large DNA hypomethylated shores and long-range chromatin interactions in rice | Plant Biotechnology Journal | |

| 2023.04 | The amino acid residue E96 of Ghd8 is crucial for the formation of the flowering repression complex Ghd7‐Ghd8‐OsHAP5C in rice | Journal of Integrative Plant Biology | |

| 2023.06 | Deciphering genetic basis of developmental and agronomic traits by integrating high-throughput optical phenotyping and genome-wide association studies in wheat | Plant Biotechnology Journal | |

| 2023.05 | Complex genetic architecture underlying the plasticity of maize agronomic traits | Plant Communications | |

| 2023.03 | Ribosome profiling reveals the translational landscape and allele-specific translational efficiency in rice | Plant Communications | |

| 2023.07 | Histone H3 lysine 27 trimethylation suppresses jasmonate biosynthesis and signaling to affect male fertility under high temperature in cotton | Plant Communications | |

| 2023.09 | High-quality reference genome assemblies for two Australimusa bananas provide insights into genetic diversity of the Musaceae family and regulatory mechanisms of superior fiber properties | Plant Communications | |

| 2023.09 | Identification of propranolol and derivatives that are chemical inhibitors of phosphatidate phosphatase as potential broad-spectrum fungicides | Plant Communications | |

| 2023.09 | High-quality Gossypium hirsutum and Gossypium barbadense genome assemblies reveal the centromeric landscape and evolution | Plant Communications | |

| 2023.10 | PlantCFG: A comprehensive database with web tools for analyzing candidate flowering genes in multiple plants | Plant Communications | |

| 2023.10 | The CCT transcriptional activator Ghd2 constantly delays the heading date by upregulating CO3 in rice | Journal of Genetics and Genomics | |

| 2023.11 | Two haplotype-resolved genome assemblies for AAB allotriploid bananas provide insights into banana subgenome asymmetric evolution and Fusarium wilt control | Plant Communications | |

| 2023.11 | A complete reference genome for the soybean cv. Jack | Plant Communications | |

| 2023.10 | Hi-Tag: A Simple and Efficient Method for Identifying Protein-Mediated Long-Range Chromatin Interactions with Low Cell Numbers | Science China Life Sciences | |

| 2023.04 | iBP-seq: An efficient and low-cost multiplex targeted genotyping and epigenotyping system | The Crop Journal | |

| 2023.11 | High-quality assembly and methylome of a Tibetan wild tree peony genome (Paeonia ludlowii) reveal the evolution of giant genome architecture | Horticulture Research | |

| 2023.12 | Characterizing of structural variants based on graph-genotyping provides insights into pig domestication and local adaption | Journal of Genetics and Genomics | |

| 2023.12 | Genomic evidence for climate-linked diversity loss and increased vulnerability of wild barley spanning 28 years of climate warming | Science of The Total Environment |

| 年份 | 文章 | 期刊 | 期刊分级 |

|---|---|---|---|

| 2022 | A multi-omics integrative network map of maize | Nature Genetics | A |

| 2022 | Genome sequencing reveals evidence of adaptive variation in the genus Zea | Nature Genetics | A |

| 2022 | Genomic innovation and regulatory rewiring during evolution of the cotton genus Gossypium | Nature Genetics | A |

| 2022 | Origin and chromatin remodeling of young X/Y sex chromosomes in catfish with sexual plasticity | National Science Review | A |

| 2022 | DNA demethylation affects imprinted gene expression in maize endosperm | Genome Biology | A |

| 2022 | DNA methylation underpins the epigenomic landscape regulating genome transcription in Arabidopsis | Genome Biology | A |

| 2022 | Dynamic 3D genome architecture of cotton fiber reveals subgenome-coordinated chromatin topology for 4-staged single-cell differentiation | Genome Biology | A |

| 2022 | Multi-omics analysis dissects the genetic architecture of seed coat content in Brassica napus | Genome Biology | A |

| 2022 | Comprehensive transcriptional variability analysis reveals gene networks regulating seed oil content of Brassica napus | Genome Biology | A |

| 2022 | A pan-Zea genome map for enhancing maize improvement | Genome Biology | A |

| 2022 | Hierarchical Accumulation of Histone Variant H2A.Z Regulates Transcriptional States and Histone Modifications in Early Mammalian Embryos | Advanced Science | A |

| 2022 | Heritability of tomato rhizobacteria resistant to Ralstonia | Microbiome | B |

| 2022 | Pervasive misannotation of microexons that are evolutionarily conserved and crucial for gene function in plants | Nature Communications | B |

| 2022 | A NAC-EXPANSIN module enhances maize kernel size by controlling nucellus elimination | Nature Communications | B |

| 2022 | ChromLoops: a comprehensive database for specific protein-mediated chromatin loops in diverse organisms | Nucleic Acids Research | B |

| 2022 | CottonMD: a multi-omics database for cotton biological study | Nucleic Acids Research | B |

| 2022 | Coordination of zygotic genome activation entry and exit by H3K4me3 and H3K27me3 in porcine early embryos | Genome Research | B |

| 2022 | DeepBSA: A deep-learning algorithm improves bulked segregant analysis for dissecting complex traits | Molecular Plant | B |

| 2022 | Starch phosphorylase 2 is essential for cellular carbohydrate partitioning in maize | Journal of Integrative Plant Biology | |

| 2022 | Constructing the maize inflorescence regulatory network by using efficient tsCUT&Tag assay | The Crop Journal | |

| 2022 | Precision Probiotics in Agroecosystems: Multiple Strategies of Native Soil Microbiotas for Conquering the Competitor Ralstonia solanacearum | Msystems | |

| 2022 | Molecular evidence for adaptive evolution of drought tolerance in wild | New Phytologist | |

| 2022 | eQTLs play critical roles in regulating gene expression and identifying key regulators in rice | Plant Biotechnology Journal | |

| 2022 | Genome‑wide association study identifies new loci for 1000‑seed weight in Brassica napus | Euphytica | |

| 2022 | Genome‑wide association study identifies candidate genes and favorable haplotypes for seed yield in Brassica napus | Molecular Breeding | |

| 2022 | Stomata at the crossroad of molecular interaction between biotic and abiotic stress responses in plants | Frontiers in plant science | |

| 2022 | Identification of a candidate gene underlying qHKW3, a QTL for hundred-kernel weight in maize | Theoretical and Applied Genetics | |

| 2022 | Sexually Dimorphic Gene Expression in X and Y Sperms Instructs Sexual Dimorphism of Embryonic Genome Activation in Yellow Catfish | Biology (Basel) |

| 年份 | 文章 | 期刊 | 期刊分级 |

|---|---|---|---|

| 2021 | Using high-throughput multiple optical phenotyping to decipher the genetic architecture of maize drought tolerance | Genome Biology | A |

| 2021 | The genetic mechanism of heterosis utilization in maize improvement | Genome Biology | A |

| 2021 | Cotton pan-genome retrieves the lost sequences and genes during domestication and selection | Genome Biology | A |

| 2021 | ASMdb: a comprehensive database for allele-specific DNA methylation in diverse organisms | Nucleic Acids Research | B |

| 2021 | An inferred functional impact map of genetic variants in rice | Molecular Plant | B |

| 2021 | Comparative Genome Analyses Highlight TransposonMediated Genome Expansion and the Evolutionary Architecture of 3D Genomic Folding in Cotton | Molecular Biology and Evolution | B |

| 2021 | Two gap-free reference genomes and a global view of the centromere architecture in rice | Molecular Plant | B |

| 2021 | Calling large indels in 1047 Arabidopsis with IndelEnsembler | Nucleic Acids Research | B |

-

常用比对软件及fq文件处理工具 seqkit 等均已支持直接使用fq.gz压缩文件,原始fq.gz文件如无必要,不要解压;

-

下载完sra文件之后,直接转成fq.gz文件,然后删掉sra文件,如无必要切勿直接转成fq文件;

-

比对过程中不要直接输出sam文件,可以利用管道组合其他工具(samtools等)或软件自带参数输出 bam 文件。相比sam,bam可节省约60%的存储空间。部分软件(gatk、sentieon等)后续流程支持cram,因此bam可以继续转成 cram 格式,可节省约30%-50%的存储空间;相应的文档可参考 短序列比对输出bam ;

-

文章发表后原始fq已经上传ncbi等数据,如无必要可直接将原始数据删除,后面需要使用时下载比较方便;

-

需要长期存放的群体数据(

fq/bam/vcf),可以使用 genozip 压缩,相比gzip,可以节省至少50%以上的存储空间,支持fq/bam/vcf等多种文件的压缩及多种压缩模式,使用参考 genozip ; -

大量的 vcf 建议使用 bgzip 压缩后再使用,同时也可以用tabix建索引,方便操作非常大的vcf文件,具体见 tabix操作VCF文件 ;

-

数据处理过程中如生成较大的文本文件,建议压缩成gz格式,linux命令和各编程语言均支持直接处理gz文件,参考 gzip文件读写 ;

-

一般文本文件压缩除使用gzip外,也可以使用 pigz(支持多线程) 来加速文件压缩解压;

-

集群存储不支持被删除数据恢复,重要的数据及时本地备份,避免误删;

-

大量小文件会影响集群性能,数据处理过程中生成的大量小文件需及时删除,如maker和Trinity的中间文件、软件源码等;

-

每个集群账号均有一定的存储配额,超过配额无法写入数据,如有大量数据在处理,建议定期使用 diskquota 命令查看存储使用情况,避免超过使用配额导致程序挂掉;

-

大量文件拷贝和跨服务器传输建议使用 rsync ,方便校验数据拷贝和传输是否完整,也可避免重复拷贝和传输;

-

从服务器上传或下载原始数据后,建议做 md5校验 ,避免各种原因导致的数据传输不完整,具体使用参考文件 文件完整性检查;

-

数据较大的数据库 (nr、nt、interproscan等) 建议使用集群已下载好的,不要自己下载;

-

用户组之间数据共享切不可简单地通过将home目录权限设置为 777 来实现,建议使用 ACL 精确地控制目录权限,以实现安全地与其它用户或用户组共享数据的目的,参考文档 数据共享;

GPU节点介绍和基本使用¶

本集群配备了 3 个 GPU 节点 gpu01、gpu03、gpu04,每个节点 2 张 GPU 卡。这两个节点单独划分给了 gpu 队列,作业脚本中指定队列为 gpu( #BSUB -q gpu )才能使用 GPU 节点。使用该队列需向管理员申请。

具体显卡配置如下

| 节点 | 显卡型号 | 单卡显存 | 数量 | 默认cuda版本 |

|---|---|---|---|---|

| gpu01 | P100 | 16G | 2 | 12.2 |

| gpu03 | 4090D | 24G | 8 | 12.4 |

| gpu04 | 4090D | 24G | 8 | 12.4 |

如需其它 cuda 版本,可使用 module 加载,如 module load cuda/10.2

作业脚本

#BSUB -J train

#BSUB -n 16

#BSUB -R span[hosts=1]

#BSUB -o %J.out

#BSUB -e %J.err

#BSUB -q gpu

python train.py

如果需要使用更多的显卡和显存,可以使用选项 #BSUB -gpu "num=2:gmem=18G",这样可以申请使用 2 张显卡,每张 18G 显存。每个人最多申请 8 张卡,根据资源紧张程度管理员可能会上调或下调每人最多使用的 GPU 卡数量。

如果需要指定节点运行,可以使用选项 #BSUB -m gpu03 指定 gpu03 节点运行作业。

深度学习库¶

python深度学习库集群没有预装,需要用户自行安装。这里以tensorflow为例来说明如何在集群上安装和使用深度学习库。

如果没有安装 conda 或 pip,参考 mambaforge。

conda安装¶

需要先通过交互模式进入GPU节点 bsub -q interactive -gpu "num=1" -Is bash

#创建conda环境,可以指定为python版本,如 conda create -n tf python=3.6

conda create -n tf

#激活环境

source activate tf

#安装TensorFlow,亦可指定版本,如 conda install tensorflow==1.14

conda install tensorflow

#测试安装效果

python -c "import tensorflow as tf;print(tf.reduce_sum(tf.random.normal([1000, 1000])))"

pip安装¶

需要先通过交互模式进入GPU节点 bsub -q interactive -gpu "num=1" -Is bash

# 创建虚拟环境,其中 `./tf_venv` 为虚拟环境目录,此后所有该虚拟环境的包都会安装在该目录下

python3 -m venv ./tf_venv

#激活环境

source ./tf_venv/bin/activate

#安装TensorFlow,可指定版本,如 pip install --upgrade tensorflow==1.15,1.15为TensorFlow 1.x的最终版本

pip install --upgrade tensorflow

#测试安装效果

python -c "import tensorflow as tf;print(tf.reduce_sum(tf.random.normal([1000, 1000])))"

singularity镜像¶

NVIDIA官方自己构建的pytorch和TensorFlow的容器镜像,每个里面包含了cuda、显卡驱动以及cudnn,据说比自己装的速度要快,使用时singularity需要 --nv 选项。

集群上下载了部分NVIDIA的官方深度学习库镜像,目录为 /share/Singularity/nvidia

使用举例

需要先通过交互模式进入GPU节点 bsub -q interactive -gpu "num=1" -Is bash

module load Singularity/3.7.3

singularity exec --nv /share/Singularity/nvidia/tensorflow_20.11-tf2-py3.sif python -c "import tensorflow as tf;print(tf.reduce_sum(tf.random.normal([1000, 1000])))"

查看GPU资源使用¶

使用lsload -gpuload 命令可以查看所有GPU卡的资源使用情况。

$ lsload -gpuload

HOST_NAME gpuid gpu_model gpu_mode gpu_temp gpu_ecc gpu_ut gpu_mut gpu_mtotal gpu_mused gpu_pstate gpu_status gpu_error

gpu01 0 TeslaP100_P 0.0 34C 0.0 0% 0% 16G 107M 0 ok -

1 TeslaP100_P 0.0 33C 0.0 0% 0% 16G 107M 0 ok -

gpu03 0 NVIDIAGeFor 0.0 30C 0.0 0% 0% 23.9G 353M 8 ok -

1 NVIDIAGeFor 0.0 30C 0.0 0% 0% 23.9G 353M 8 ok -

2 NVIDIAGeFor 0.0 29C 0.0 0% 0% 23.9G 353M 8 ok -

3 NVIDIAGeFor 0.0 28C 0.0 0% 0% 23.9G 353M 8 ok -

4 NVIDIAGeFor 0.0 29C 0.0 0% 0% 23.9G 353M 8 ok -

5 NVIDIAGeFor 0.0 42C 0.0 0% 0% 23.9G 8.9G 2 ok -

6 NVIDIAGeFor 0.0 31C 0.0 0% 0% 23.9G 353M 8 ok -

7 NVIDIAGeFor 0.0 30C 0.0 0% 0% 23.9G 353M 8 ok -

gpu04 0 NVIDIAGeFor 0.0 47C 0.0 73% 1% 23.9G 13.1G 2 ok -

1 NVIDIAGeFor 0.0 29C 0.0 0% 0% 23.9G 353M 8 ok -

2 NVIDIAGeFor 0.0 28C 0.0 0% 0% 23.9G 353M 8 ok -

3 NVIDIAGeFor 0.0 45C 0.0 80% 3% 23.9G 13.1G 2 ok -

4 NVIDIAGeFor 0.0 30C 0.0 0% 0% 23.9G 353M 8 ok -

5 NVIDIAGeFor 0.0 29C 0.0 0% 0% 23.9G 353M 8 ok -

6 NVIDIAGeFor 0.0 30C 0.0 0% 0% 23.9G 353M 8 ok -

7 NVIDIAGeFor 0.0 30C 0.0 0% 0% 23.9G 353M 8 ok -

gpu02 0 UnknownNVID 0.0 32C 0.0 0% 0% 44.9G 479M 8 ok -

bjobs -l -gpu jobid 查看作业具体使用的是哪张卡,如下所示,该作业使用的 gpu04 节点上 ID 为 3 的 GPU 卡,作业申请了 16 个 CPU 核心,这张卡有 23.9G 的显存,作业申请保留了11264M 的显存。

$ bjobs -l -gpu jobid

...

EXTERNAL MESSAGES:

MSG_ID FROM POST_TIME MESSAGE ATTACHMENT

0 sswu Apr 2 09:28 gpu04:gpus=3; N

...

GPU_ALLOCATION:

HOST TASK ID MODEL MTOTAL FACTOR MRSV SOCKET NVLINK

gpu04 0 3 NVIDIAGeForc 23.9G 8.9 11264 0 -

1 3 NVIDIAGeForc 23.9G 8.9 0 0 -

2 3 NVIDIAGeForc 23.9G 8.9 0 0 -

3 3 NVIDIAGeForc 23.9G 8.9 0 0 -

4 3 NVIDIAGeForc 23.9G 8.9 0 0 -

5 3 NVIDIAGeForc 23.9G 8.9 0 0 -

6 3 NVIDIAGeForc 23.9G 8.9 0 0 -

7 3 NVIDIAGeForc 23.9G 8.9 0 0 -

8 3 NVIDIAGeForc 23.9G 8.9 0 0 -

9 3 NVIDIAGeForc 23.9G 8.9 0 0 -

10 3 NVIDIAGeForc 23.9G 8.9 0 0 -

11 3 NVIDIAGeForc 23.9G 8.9 0 0 -

12 3 NVIDIAGeForc 23.9G 8.9 0 0 -

13 3 NVIDIAGeForc 23.9G 8.9 0 0 -

14 3 NVIDIAGeForc 23.9G 8.9 0 0 -

15 3 NVIDIAGeForc 23.9G 8.9 0 0 -

FAQ¶

-

GPU卡显存不足报错,RuntimeError: CUDA error: out of memory

一般是显卡上已经有其它程序在运行占用了部分显存导致的,可手动指定程序使用其它空闲显卡来解决

import os os.environ['CUDA_VISIBLE_DEVICES'] = "0" #或1 -

gpu02上的k4m支持pytorch最高版本为1.2

micromamba create -n pytorch12 python==3.7 micromamba activate pytorch12 conda install pytorch=1.2 torchvision

速度测试¶

$ python pytorch_benchmark.py -h

usage: pytorch_benchmark.py [-h] [-i I] [-e E] [-bp BP] [-bs BS]

Used to check pytorch speed benchmark.

optional arguments:

-h, --help show this help message and exit

-i I Card id. Which cuda card do you want to test. default: 0

-e E Epoch. defaule: 500

-bp BP Use backward. defaule: True

-bs BS Batch size. defaule: 8

# -e 改变问题规模,同等规模,运行时间越短,速度越快

# -i 指定显卡id

$ python pytorch_benchmark.py -e 50 -i 0

Speed benchmark begin.

Speed benchmark finish.

Result

cuda_time: 56.0926796875

perf_counter_time: 56.09359596297145

no_num_error: True

deterministic: True

benchmark: False

platform: Linux-3.10.0-862.el7.x86_64-x86_64-with-centos-7.5.1804-Core

machine: x86_64

python_build: ('default', 'Oct 9 2018 10:31:47')

test_time: 2023-02-25T17:39:57.235769

'''

用于测试显卡速度

'''

import os

import torch

import torch.nn as nn

from torch.backends import cudnn

import argparse

import time

import datetime

import platform

os.environ["CUDA_VISIBLE_DEVICES"]="0"

def ConvBnAct(in_ch, out_ch, ker_sz, stride, pad, act=nn.Identity(), group=1, dilation=1):

return nn.Sequential(nn.Conv2d(in_ch, out_ch, ker_sz, stride, pad, groups=group, bias=False, dilation=dilation),

nn.GroupNorm(16, out_ch, eps=1e-8),

act)

def DeConvBnAct(in_ch, out_ch, ker_sz, stride, pad, act=nn.Identity(), group=1, dilation=1):

return nn.Sequential(nn.ConvTranspose2d(in_ch, out_ch, ker_sz, stride, pad, groups=group, bias=False, dilation=dilation),

nn.GroupNorm(16, out_ch, eps=1e-8),

act)

class RevSequential(nn.ModuleList):

'''

功能大部分与ModuleList重叠

'''

def __init__(self, modules=None):

super().__init__(modules)

def append(self, module):

assert hasattr(module, 'invert') and callable(module.invert)

super().append(module)

def extend(self, modules):

for m in modules:

self.append(m)

def forward(self, x1, x2):

y1, y2 = x1, x2

for m in self:

y1, y2 = m(y1, y2)

return y1, y2

def invert(self, y1, y2):

x1, x2 = y1, y2

for m in list(self)[::-1]:

x1, x2 = m.invert(x1, x2)

return x1, x2

class RevGroupBlock(RevSequential):

'''

当前只支持输入通道等于输出通道,并且不允许下采样

'''

def __init__(self, in_ch, out_ch, stride, act, block_type, blocks, **kwargs):

assert in_ch == out_ch

assert stride == 1

mods = []

for _ in range(blocks):

mods.append(block_type(in_ch=in_ch, out_ch=out_ch, stride=1, act=act, **kwargs))

# self.extend(mods)

super().__init__(mods)

class RevBlockC(nn.Module):

def __init__(self, in_ch, out_ch, stride, act, **kwargs):

super().__init__()

inter_ch = in_ch // 2

self.conv1 = ConvBnAct(in_ch, inter_ch, ker_sz=5, stride=1, pad=2, act=act)

self.conv2 = ConvBnAct(inter_ch, inter_ch, ker_sz=5, stride=1, pad=2, act=act, group=inter_ch)

self.conv3 = ConvBnAct(in_ch, in_ch, ker_sz=1, stride=1, pad=0, act=nn.Identity())

def func(self, x):

y1 = self.conv1(x)

y2 = self.conv2(y1)

y = torch.cat([y1, y2], dim=1)

y = self.conv3(y)

return y

def forward(self, x1, x2):

y = x1 + self.func(x2)

return x2, y

def invert(self, y1, y2):

x2, y = y1, y2

x1 = y - self.func(x2)

return x1, x2

def new_model():

act = nn.ELU()

rvb = RevGroupBlock(128, 128, 1, act, RevBlockC, 12).to(device)

rvb.eval()

return rvb

if __name__ == '__main__':

cudnn.benchmark = False

cudnn.deterministic = True

torch.set_grad_enabled(False)

parse = argparse.ArgumentParser(description='Used to check pytorch speed benchmark.')

parse.add_argument('-i', type=int, help='Card id. Which cuda card do you want to test. default: 0', default=0)

parse.add_argument('-e', type=int, help='Epoch. defaule: 500', default=500)

parse.add_argument('-bp', type=bool, help='Use backward. defaule: True', default=True)

parse.add_argument('-bs', type=int, help='Batch size. defaule: 8', default=8)

parse = parse.parse_args()

card_id = parse.i

epoch = parse.e

use_backward = parse.bp

batch_size = parse.bs

# 使用cpu测试理论上是永远不会报错的

device = 'cpu' if card_id == -1 else f'cuda:{card_id}'

device = torch.device(device)

assert epoch > 0

assert batch_size > 0

rvb = new_model()

is_no_num_error = True

torch.set_grad_enabled(use_backward)

start_record = torch.cuda.Event(enable_timing=True)

end_record = torch.cuda.Event(enable_timing=True)

print('Speed benchmark begin.')

start_time = time.perf_counter()

start_record.record()

for e in range(epoch):

e = e+1

a1 = torch.randn(batch_size, 128, 64, 64, device=device)

b1, b2 = rvb(a1, a1)

o_a1, o_a2 = rvb.invert(b1, b2)

if use_backward:

(o_a1.max() + o_a2.max()).backward()

with torch.no_grad():

max_diff_1 = torch.abs(o_a1 - o_a2).max().item()

max_diff_2 = torch.abs(a1 - o_a1).max().item()

# cur_time = time.perf_counter()

# cost_time = cur_time-start_time

# guess_full_cost_time = cost_time / e * epoch

#

# line = f'card_id: {card_id} elapsed/total: {e}/{epoch} time: {int(cost_time)}/{int(guess_full_cost_time)} md1: {max_diff_1:.8f} md2: {max_diff_2:.8f}'

# print(line)

if max_diff_1 > 1e-3 or max_diff_2 > 1e-3:

print(f'A large numerical error was found! diff_1: {max_diff_1:.8f} diff_2: {max_diff_2:.8f}')

is_no_num_error = False

end_record.record()

torch.cuda.synchronize()

end_time = time.perf_counter()

cuda_time = start_record.elapsed_time(end_record) / 1000

perf_counter_time = end_time - start_time

print('Speed benchmark finish.')

result = {

'cuda_time': cuda_time,

'perf_counter_time': perf_counter_time,

'no_num_error': is_no_num_error,

'deterministic': cudnn.deterministic,

'benchmark': cudnn.benchmark,

'platform': platform.platform(),

'machine': platform.machine(),

'python_build': platform.python_build(),

# 'device': 'cpu' if device == torch.device('cpu') else torch.cuda.get_device_name(device),

# 'cuda_version': '' if device == torch.device('cpu') else torch.cuda_version,

'test_time': datetime.datetime.now().isoformat(),

}

print('Result')

for k, v in result.items():

print(f'{k}: {v}')

参考资料:

扫描大文本文件并压缩¶

扫描当前账号下,大于100M的文本文件,fq、fa、sam、vcf、bed等,将扫描出来的文件列表存放于filestxt_username_211124文件中。

bsub -n 5 -J scan -o filecan.out -e filescan.err "ls -d ~/* |xargs -I[] -P 5 find [] -size +100M -type f -exec sh ASCII.sh {} \; >filetxt_username_211124"

sam文件建议排序并转成bam或cram存放,如果已有对应的bam文件,sam文件直接删除即可。

fq的rawdata和cleandata只保留其中一份即可。

bsub -n 5 -J gzip -o filegzip.out -e filesgzip.err "cat filetxt_username_211124|awk '{print \$2}'|xargs -P 5 -i sh gzip.sh {} > filegzip_username_211124 2>&1"

#!/bin/sh

na=$1

ty=`file -b $1|xargs echo -n|cut -d" " -f 1`

si=`du -sm $1`

if [ $ty == ASCII ];then

echo $si

fi

#!/bin/sh

file=$1

if [ -f $file ];then

echo $file

gzip $file

fi

扫描所有大文件¶

扫描当前账号下所有大于100M的文件,建议不再使用的文件或从服务器下载备份或删除。

bsub -n 5 -J scan -o filecan.out -e filescan.err "ls -d ~/* |xargs -I[] -P 5 find [] -size +100M -type f |xargs du -sm >fileall_username_211124"